Трансформаторы ТСКС-10 / ТСКС-16 / ТСКС-25 / ТСКС-40 — Силектра

Описание

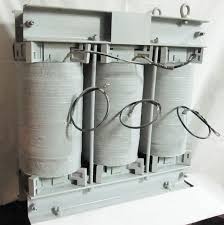

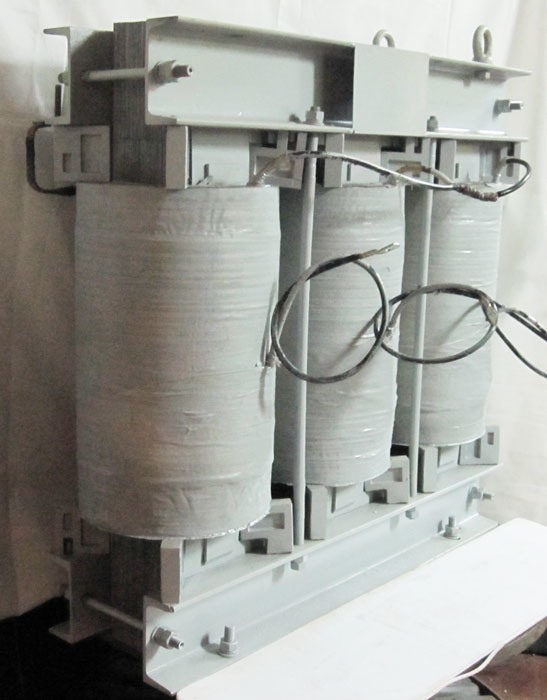

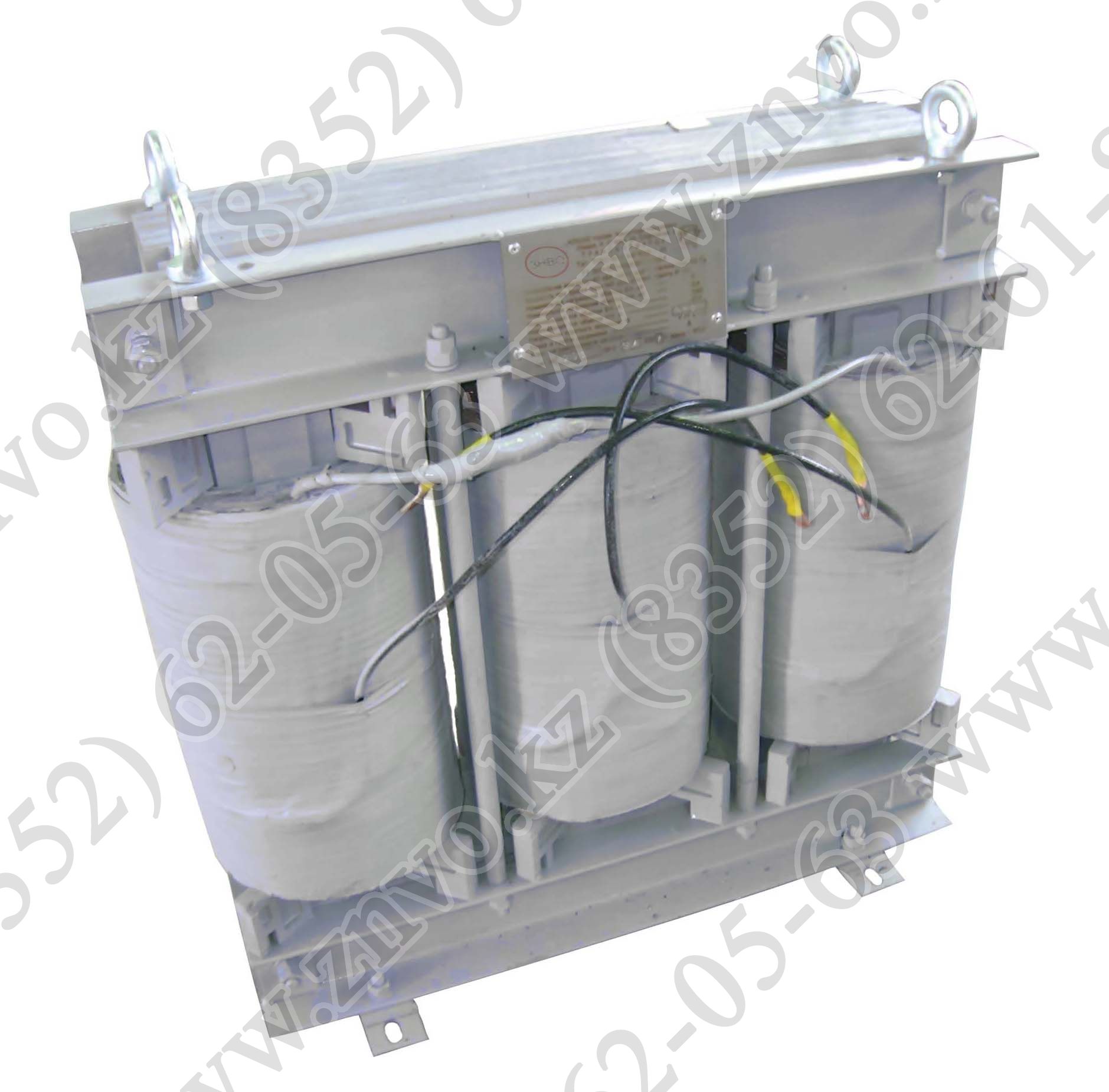

Трансформаторы ТСКС-10 / ТСКС-16 / ТСКС-25 / ТСКС-40Трехфазные сухие трансформаторы специального назначения типа ТСКС мощностью 10; 16; 25 и 40 кВА предназначены для собственных нужд шкафов (ячеек) КРУ класса напряжения 6 и 10 кВ.

Трансформаторы силовые типа ТСКС имеют высокую надежность, пожаробезопасны, т.к обмотки и изоляционные детали активной части трансформаторов выполнены из материалов, не поддерживающих горения. Трансформаторы требуют минимальных затрат на обслуживание, экономичны и просты в эксплуатации.

Трансформаторы ТСКС незащищенного исполнения (степень защиты IP00), выполнены с облегченной изоляцией.

Класс нагревостойкости – F.

Вид климатического исполнения – УХЛ.

Категория размещения – 4.

Режим работы – продолжительный.

Температура окружающего воздуха – от +1ºС до + 40ºС.

Относительная влажность воздуха при +25ºС – не более 80%.

Корректированный уровень звуковой мощности не более 60 дБА.

Трансформаторы должны эксплуатироваться в следующих условиях:

а) высота над уровнем моря не более 1000 м;

в) трансформаторы не предназначены для работы в условиях тряски, вибрации, ударов, взрывоопасной и химически агрессивной среды.

Частота питающей сети – 50Гц.

Напряжение на стороне ВН – 6; 6,3; 10; 10,5 кВ.

Напряжение на стороне НН – 0,4; 0,23 кВ.

По требованию заказчика завод может изготовить трансформаторы на сторонах ВН и НН с иными значениями напряжений.

Готовы изготовить нестандартные трансформаторы. Вся продукция сертифицирована по системе сертификации ГОСТ Р Госстандарта России и имеет сертификаты соответствия.

Материал обмоток – медь.

По требованию заказчика трансформаторы комплектуются блоком контроля температуры (за дополнительную плату).

Схема и группа соединения – Y/Yн-0; Д/Yн-11; Y/Д-11.

ОСНОВНЫЕ ТЕХНИЧЕСКИЕ ХАРАКТЕРИСТИКИ

| Тип трансформатора | Мощность, кВА | Напряжение к. з. при 75ºС з. при 75ºС | Потери, Вт | Габаритные размеры, мм | Масса, кг | |||||

| х.х. | к.з. при 75ºС | L | В | Н | А | А1 | ||||

| ТСКС-10 | 10 | 2,5 | 80 | 300 | 610 | 260 | 635 | 400 | 240 | |

| ТСКС-16 | 16 | 120 | 500 | 270 | ||||||

| ТСКС-25 | 25 | 160 | 700 | 645 | 455 | 740 | 450 | 360 | 270 | |

| ТСКС-40 | 38 | 1,5 | 360 | 500 | 695 | 290 | 760 | 480 | 250 | 370 |

Трансформатор ТСКС 40/145/10 — ЦКС

Наличие

Склад Казань

по запросу

Склад Краснодар

по запросу

Склад Москва

по запросу

Склад Нижневартовск

по запросу

Склад Нижний Новгород

по запросу

Склад Пермь

по запросу

Склад Ростов-на-Дону

по запросу

Склад Сургут

по запросу

Склад Тюмень

по запросу

Склад Уфа

по запросу

Склад Челябинск

по запросу

Как работают трансформеры? — Hugging Face Course

В этом разделе мы подробно рассмотрим архитектуру моделей Transformer.

Немного истории Трансформера

Вот некоторые ориентиры из (короткой) истории моделей Transformer:

Архитектура Transformer была представлена в июне 2017 года. Основное внимание в первоначальном исследовании уделялось задачам перевода. За этим последовало введение нескольких влиятельных моделей, в том числе:

Июнь 2018 г. : GPT, первая предварительно обученная модель Transformer, используемая для тонкой настройки различных задач НЛП и позволяющая получить самые современные результаты

Октябрь 2018 г. : BERT, еще одна большая предварительно обученная модель, предназначенная для создания более качественных сводок предложений (подробнее об этом в следующей главе!)

Февраль 2019 г. : GPT-2, улучшенная (и увеличенная) версия GPT, которая не была сразу опубликована из соображений этики

Октябрь 2019 г. : DistilBERT, очищенная версия BERT, которая на 60 % быстрее, на 40 % меньше памяти и при этом сохраняет 97 % производительности BERT

Октябрь 2019 г.

: BART и T5, две большие предварительно обученные модели, использующие ту же архитектуру, что и исходная модель Transformer (первая, которая сделала это)

: BART и T5, две большие предварительно обученные модели, использующие ту же архитектуру, что и исходная модель Transformer (первая, которая сделала это)Май 2020 г. , GPT-3, еще более крупная версия GPT-2, способная хорошо выполнять различные задачи без необходимости тонкой настройки (называется обучение нулевому выстрелу )

Этот список далеко не исчерпывающий и предназначен только для выделения нескольких различных типов моделей Transformer. В целом их можно разделить на три категории:

- GPT-подобные модели (также называемые авторегрессивными моделями Transformer)

- BERT-подобные (также называемые моделями с автоматическим кодированием Transformer)

- BART/T5-подобные (также называемые моделями последовательного преобразования Transformer)

Позже мы более подробно рассмотрим эти семьи.

Трансформеры — это языковые модели

Все упомянутые выше модели Transformer (GPT, BERT, BART, T5 и т. д.) были обучены как языковые модели . Это означает, что они были обучены работе с большими объемами необработанного текста под самоконтролем. Самоконтролируемое обучение — это тип обучения, при котором цель автоматически вычисляется на основе входных данных модели. Это означает, что люди не нужны для маркировки данных!

д.) были обучены как языковые модели . Это означает, что они были обучены работе с большими объемами необработанного текста под самоконтролем. Самоконтролируемое обучение — это тип обучения, при котором цель автоматически вычисляется на основе входных данных модели. Это означает, что люди не нужны для маркировки данных!

Этот тип модели развивает статистическое понимание языка, на котором он был обучен, но он не очень полезен для конкретных практических задач. Из-за этого общая предварительно обученная модель затем проходит процесс, называемый трансферным обучением . В ходе этого процесса модель настраивается контролируемым образом, то есть с использованием аннотированных человеком меток, для данной задачи.

Пример задания — угадать следующее слово в предложении, прочитав n предыдущих слов. Это называется каузальным языковым моделированием , потому что результат зависит от прошлых и настоящих входных данных, но не от будущих.

Другим примером является моделирование маскированного языка , в котором модель предсказывает замаскированное слово в предложении.

Трансформеры большие модели

За исключением нескольких выбросов (например, DistilBERT), общая стратегия повышения производительности заключается в увеличении размеров моделей, а также объема данных, на которых они предварительно обучаются.

К сожалению, для обучения модели, особенно большой, требуется большой объем данных. Это становится очень затратным с точки зрения времени и вычислительных ресурсов. Это даже приводит к воздействию на окружающую среду, как показано на следующем графике.

А это демонстрирует проект для (очень большой) модели под руководством команды, сознательно пытающейся уменьшить воздействие предварительной подготовки на окружающую среду. След от проведения множества испытаний для получения лучших гиперпараметров будет еще выше.

Представьте себе, что каждый раз, когда исследовательская группа, студенческая организация или компания хотят обучить модель, они делают это с нуля. Это привело бы к огромным, ненужным глобальным затратам!

Вот почему совместное использование языковых моделей имеет первостепенное значение: совместное использование обученных весов и построение на основе уже обученных весов снижает общую стоимость вычислений и углеродный след сообщества.

Кстати, вы можете оценить углеродный след обучения ваших моделей с помощью нескольких инструментов. Например, ML CO2 Impact или Code Carbon, которые интегрированы в 🤗 Transformers. Чтобы узнать больше об этом, вы можете прочитать этот пост в блоге, который покажет вам, как создать mission.csv файл с оценкой площади вашей тренировки, а также документация 🤗 Transformers, посвященная этой теме.

Трансферное обучение

Предварительное обучение — это процесс обучения модели с нуля: веса инициализируются случайным образом, и обучение начинается без каких-либо предварительных знаний.

Это предварительное обучение обычно выполняется на очень больших объемах данных. Поэтому для этого требуется очень большой массив данных, а обучение может занять до нескольких недель.

Тонкая настройка , с другой стороны, это обучение, выполненное после того, как модель была предварительно обучена. Чтобы выполнить точную настройку, вы сначала получаете предварительно обученную языковую модель, а затем выполняете дополнительное обучение с набором данных, специфичным для вашей задачи. Подождите — почему бы просто не тренироваться непосредственно перед последним заданием? Есть несколько причин:

Подождите — почему бы просто не тренироваться непосредственно перед последним заданием? Есть несколько причин:

- Предварительно обученная модель уже была обучена на наборе данных, который имеет некоторое сходство с набором данных тонкой настройки. Таким образом, процесс тонкой настройки может использовать знания, полученные исходной моделью во время предварительного обучения (например, для задач НЛП предварительно обученная модель будет иметь какое-то статистическое понимание языка, который вы используете для своей задачи).

- Поскольку предварительно обученная модель уже была обучена на большом количестве данных, для точной настройки требуется намного меньше данных, чтобы получить достойные результаты.

- По той же причине количество времени и ресурсов, необходимых для получения хороших результатов, намного ниже.

Например, можно использовать предварительно обученную модель, обученную английскому языку, а затем настроить ее на корпусе arXiv, в результате чего получится научно-исследовательская модель. Для тонкой настройки потребуется лишь ограниченный объем данных: знания, полученные предварительно обученной моделью, «передаются», отсюда и термин 9.0045 перевод обучения .

Для тонкой настройки потребуется лишь ограниченный объем данных: знания, полученные предварительно обученной моделью, «передаются», отсюда и термин 9.0045 перевод обучения .

Таким образом, точная настройка модели требует меньше времени, данных, финансовых и экологических затрат. Также быстрее и проще перебирать различные схемы тонкой настройки, поскольку обучение требует меньше усилий, чем полное предварительное обучение.

Этот процесс также даст лучшие результаты, чем обучение с нуля (если только у вас нет большого количества данных), поэтому вы всегда должны пытаться использовать предварительно обученную модель — модель, максимально приближенную к поставленной задаче — и хорошо -настроить его.

Общая архитектура

В этом разделе мы рассмотрим общую архитектуру модели Transformer. Не волнуйтесь, если вы не понимаете некоторые концепции; позже есть подробные разделы, посвященные каждому из компонентов.

Введение

Модель в основном состоит из двух блоков:

- Кодировщик (слева) : Кодировщик получает входные данные и строит их представление (его функции).

Это означает, что модель оптимизирована для получения понимания из входных данных.

Это означает, что модель оптимизирована для получения понимания из входных данных. - Декодер (справа) : Декодер использует представление (функции) кодировщика вместе с другими входными данными для создания целевой последовательности. Это означает, что модель оптимизирована для получения выходных данных.

Каждая из этих частей может использоваться независимо, в зависимости от задачи:

- Модели только для кодировщика : Подходит для задач, требующих понимания входных данных, таких как классификация предложений и распознавание именованных объектов.

- Модели только с декодером : Подходит для генеративных задач, таких как генерация текста.

- Модели кодировщик-декодер или модели последовательностей последовательностей : Хорошо подходит для генеративных задач, требующих ввода, таких как преобразование или суммирование.

Мы рассмотрим эти архитектуры отдельно в следующих разделах.

Слои внимания

Ключевой особенностью моделей Transformer является то, что они состоят из специальных слоев, называемых слоями внимания . На самом деле, название документа, посвященного архитектуре Transformer, было «Внимание — это все, что вам нужно»! Мы рассмотрим детали слоев внимания позже в этом курсе; на данный момент все, что вам нужно знать, это то, что этот слой скажет модели обращать особое внимание на определенные слова в предложении, которое вы ему передали (и более или менее игнорировать другие) при работе с представлением каждого слова.

Чтобы понять это, рассмотрим задачу перевода текста с английского на французский. Учитывая ввод «Вам нравится этот курс», модель перевода должна будет также учитывать соседнее слово «Вы», чтобы получить правильный перевод слова «нравится», потому что во французском языке глагол «нравится» спрягается по-разному в зависимости от предмет. Однако остальная часть предложения бесполезна для перевода этого слова. В том же духе при переводе «это» модели также необходимо будет обратить внимание на слово «курс», потому что «это» переводится по-разному в зависимости от того, является ли связанное существительное мужским или женским. Опять же, другие слова в предложении не будут иметь значения для перевода «этого». С более сложными предложениями (и более сложными грамматическими правилами) модели потребуется уделять особое внимание словам, которые могут оказаться дальше в предложении, чтобы правильно перевести каждое слово.

В том же духе при переводе «это» модели также необходимо будет обратить внимание на слово «курс», потому что «это» переводится по-разному в зависимости от того, является ли связанное существительное мужским или женским. Опять же, другие слова в предложении не будут иметь значения для перевода «этого». С более сложными предложениями (и более сложными грамматическими правилами) модели потребуется уделять особое внимание словам, которые могут оказаться дальше в предложении, чтобы правильно перевести каждое слово.

Та же концепция применима к любой задаче, связанной с естественным языком: слово само по себе имеет значение, но это значение сильно зависит от контекста, которым может быть любое другое слово (или слова) до или после изучаемого слова.

Теперь, когда у вас есть представление о том, что такое уровни внимания, давайте подробнее рассмотрим архитектуру Transformer.

Оригинальная архитектура

Архитектура Transformer изначально была разработана для трансляции. Во время обучения кодировщик получает входные данные (предложения) на определенном языке, а декодер получает те же предложения на желаемом целевом языке. В кодировщике уровни внимания могут использовать все слова в предложении (поскольку, как мы только что видели, перевод данного слова может зависеть от того, что в предложении находится после него, а также перед ним). Декодер, однако, работает последовательно и может обращать внимание только на слова в предложении, которые он уже перевел (то есть только на слова перед генерируемым в данный момент словом). Например, когда мы предсказали первые три слова переведенной цели, мы передаем их декодеру, который затем использует все входные данные кодировщика, чтобы попытаться предсказать четвертое слово.

Во время обучения кодировщик получает входные данные (предложения) на определенном языке, а декодер получает те же предложения на желаемом целевом языке. В кодировщике уровни внимания могут использовать все слова в предложении (поскольку, как мы только что видели, перевод данного слова может зависеть от того, что в предложении находится после него, а также перед ним). Декодер, однако, работает последовательно и может обращать внимание только на слова в предложении, которые он уже перевел (то есть только на слова перед генерируемым в данный момент словом). Например, когда мы предсказали первые три слова переведенной цели, мы передаем их декодеру, который затем использует все входные данные кодировщика, чтобы попытаться предсказать четвертое слово.

Чтобы ускорить процесс во время обучения (когда модель имеет доступ к целевым предложениям), декодер получает цель целиком, но ему не разрешается использовать будущие слова (если он имел доступ к слову в позиции 2 при попытке предсказать слово на позиции 2, задача будет несложной!). Например, при попытке предсказать четвертое слово уровень внимания будет иметь доступ только к словам в позициях с 1 по 3.

Например, при попытке предсказать четвертое слово уровень внимания будет иметь доступ только к словам в позициях с 1 по 3.

Первоначальная архитектура Transformer выглядела так, с энкодером слева и декодером справа:

Обратите внимание, что первый уровень внимания в блоке декодера обращает внимание на все (прошлые) входные данные декодера, а второй уровень внимания использует выходные данные кодера. Таким образом, он может получить доступ ко всему входному предложению, чтобы наилучшим образом предсказать текущее слово. Это очень полезно, так как разные языки могут иметь грамматические правила, которые располагают слова в разном порядке, или некоторый контекст, предоставленный позже в предложении, может быть полезен для определения наилучшего перевода данного слова.

9Маска внимания 0045 также может использоваться в кодере/декодере, чтобы модель не обращала внимания на некоторые специальные слова — например, на специальное слово-заполнитель, используемое для придания всем входным данным одинаковой длины при группировании предложений.

Архитектуры против контрольных точек

Когда мы углубимся в модели Transformer в этом курсе, вы увидите упоминания архитектур и контрольных точек , а также моделей . Все эти термины имеют немного разные значения:

- Архитектура : Это скелет модели — определение каждого слоя и каждой операции, происходящей в модели.

- Контрольные точки : Это веса, которые будут загружены в данной архитектуре.

- Модель : это общий термин, который не так точен, как «архитектура» или «контрольно-пропускной пункт»: он может означать и то, и другое. В этом курсе будет указана архитектура или контрольная точка , когда это необходимо для уменьшения неоднозначности.

Например, BERT — это архитектура, а bert-base-cased — набор весов, подготовленный командой Google для первого выпуска BERT, — контрольная точка. Тем не менее, можно сказать «модель BERT» и «модель в базовом корпусе ».

Что такое трансформеры в НЛП и их преимущества

Аюш Шривастава AI, искусственный интеллект, машинное обучение, искусственный интеллект и обработка данных

Время чтения: 4 минуты

Трансформатор НЛП — это новая архитектура, предназначенная для последовательного решения задач и простой обработки удаленных зависимостей. Вычисление входных и выходных представлений без использования RNN или сверток, выровненных по последовательности, полностью зависит от собственного внимания. Давайте подробно рассмотрим, что такое трансформеры.

Базовая архитектура

В целом модель Transformer основана на архитектуре кодер-декодер. Кодировщик — серый прямоугольник слева, а декодер — справа. Кодер и декодер состоят из двух и трех подуровней соответственно. Самосознание с несколькими головками, полностью подключенная сеть прямой связи и самосознание кодера-декодера в случае декодеров (называемое многоголовым вниманием) со следующими визуализациями).

Кодер: Кодер отвечает за пошаговое выполнение входных временных шагов и кодирование всей последовательности в вектор фиксированной длины, называемый вектором контекста.

Декодер: Декодер отвечает за пошаговое выполнение выходных временных шагов при чтении из вектора контекста.

Давайте посмотрим, как работает эта установка кодировщика и стека декодера:

1. Словесные вложения входной последовательности передаются первому кодировщику

2. Затем они преобразуются и передаются следующему кодировщику

3. Выходные данные последнего кодера в стеке кодировщиков передаются всем декодерам в стеке декодеров, как показано на рисунке ниже:

Что именно делает этот слой «Самостоятельное внимание» в Transformer?

Само-внимание в трансформерах

Само-внимание — это новый взгляд на технику внимания. Вместо того, чтобы смотреть на предшествующие скрытые векторы при рассмотрении встраивания слов, само-внимание представляет собой взвешенную комбинацию всех других вложений слов (включая те, которые появляются позже в предложении):

Как реализовано самовнимание :

Шаги:

1. Вложение слов преобразуется в три отдельные матрицы — запросы, ключи и значения — путем умножения вложения слов на три матрицы с выучил веса. Эти векторы обучаются и обновляются в процессе обучения.

Вложение слов преобразуется в три отдельные матрицы — запросы, ключи и значения — путем умножения вложения слов на три матрицы с выучил веса. Эти векторы обучаются и обновляются в процессе обучения.

2. Рассмотрим это предложение — «действие приводит к результатам». Чтобы рассчитать самосознание первого слова «действие», подсчитайте баллы всех слов во фразе, связанной с «действием». Эта оценка определяет важность других слов при кодировании конкретного слова во входной последовательности.

- Оценка за первое слово вычисляется путем скалярного произведения вектора запроса (q1) с векторами ключей (k1, k2, k3) всех слов

- Затем эти оценки делятся на 8, что равно квадратный корень из размерности ключевого вектора:

- Затем эти оценки нормализуются с помощью функции активации softmax

- Затем эти нормализованные оценки умножаются на векторы значений (v1, v2, v3) и суммируются результирующие векторы для получить окончательный вектор (z1).

Это результат слоя внутреннего внимания. Затем он передается в сеть прямой связи в качестве входных данных 9.0016

Это результат слоя внутреннего внимания. Затем он передается в сеть прямой связи в качестве входных данных 9.0016 - Один и тот же процесс выполняется для всех слов

В архитектуре Трансформера самосознание вычисляется независимо друг от друга, не один раз, а несколько раз параллельно. Поэтому его называют многоголовым вниманием. Выходные данные объединяются и преобразуются линейно, как показано на следующем рисунке.

Внимание в архитектуре трансформатора и его работа:Архитектура трансформатора использует модель внимания, использующую многоголовое внимание на трех этапах (см. рис. 1):

1. Первый — это уровень внимания кодировщика и декодера. Для этого типа слоя запрос берется из слоя перед декодером, а ключи и значения берутся из вывода кодировщика. Это позволяет каждой позиции декодера обращать внимание на каждую позицию во входной последовательности.

2. Второй тип — это уровень самоконтроля, содержащийся в кодере. Этот уровень получает ввод ключа, значения и запроса из вывода уровня перед кодировщиком. Любая позиция кодировщика может получать значения внимания из любой позиции слоя перед кодировщиком.

Этот уровень получает ввод ключа, значения и запроса из вывода уровня перед кодировщиком. Любая позиция кодировщика может получать значения внимания из любой позиции слоя перед кодировщиком.

3. Третий тип декодер самостоятельного внимания. Это похоже на самостоятельный поиск кодировщика, когда все запросы, ключи и значения извлекаются из предыдущего слоя. Декодер с самосознанием может использоваться в любой позиции для обслуживания любой позиции до этой позиции. Будущие значения маскируются (-Inf). Это называется скрытым вниманием к себе.

4. Выход декодера, наконец, проходит через полносвязный слой, за которым следует слой softmax, чтобы сгенерировать предсказание для следующего слова выходной последовательности.

Сравнение с RNN

Архитектура Transformer устраняет зависящий от времени аспект архитектуры RNN, обрабатывая эти аспекты обучения в совершенно отдельной архитектуре. Таким образом, преобразователь имеет столько линейных слоев, сколько слов в самом длинном предложении, но эти слои относительно просты и не зависят от времени, как и в случае RNN.

: BART и T5, две большие предварительно обученные модели, использующие ту же архитектуру, что и исходная модель Transformer (первая, которая сделала это)

: BART и T5, две большие предварительно обученные модели, использующие ту же архитектуру, что и исходная модель Transformer (первая, которая сделала это) Это означает, что модель оптимизирована для получения понимания из входных данных.

Это означает, что модель оптимизирована для получения понимания из входных данных. Это результат слоя внутреннего внимания. Затем он передается в сеть прямой связи в качестве входных данных 9.0016

Это результат слоя внутреннего внимания. Затем он передается в сеть прямой связи в качестве входных данных 9.0016