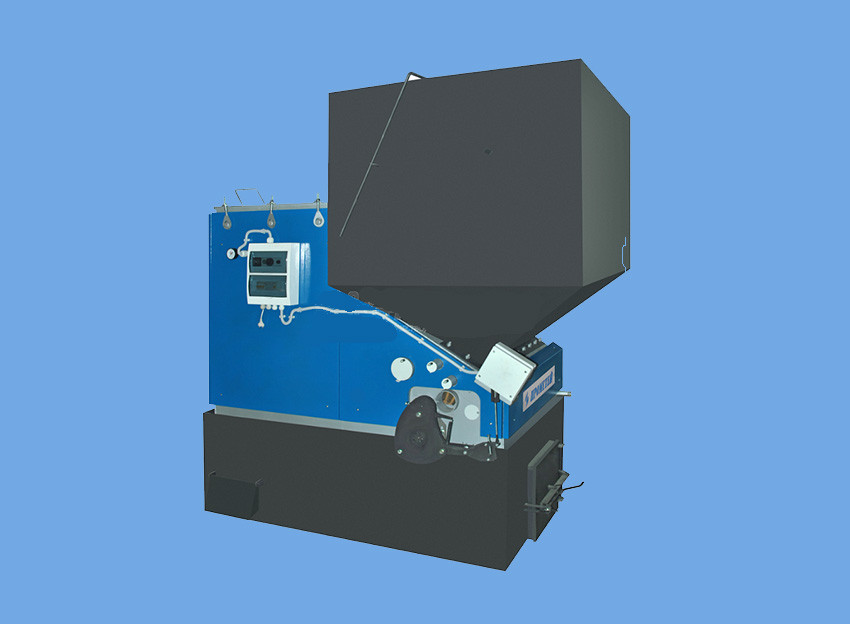

Автоматический котел ПРОМЕТЕЙ™ 40 — Прометей™

Характеристики

| Максимальная температура воды, °С | 110 |

| Теплопроизводительность (min-max), кВт | 5/40 кВт |

| Средний расход топлива, кг/ч | 8/15 |

| Поверхность теплообменника, м2 | 4 |

| КПД, в зависимости от качества топлива,% | 75/90 |

| Основное топливо котла | сухие бурые и каменные угли марки Д (5-70 мм) 3000-5500 ккал/кг |

| Объем загрузочного бункера, м3/кг | 0,3/360 |

| Объем увеличенного бункера, м3/кг | 0,6/1,0/2,3 |

Макс. рабочее давление, кгс/см2 рабочее давление, кгс/см2 | 2,5 |

| Температура дымовых газов, °С | 100-210 |

| Объем отапливаемого помещения, м3 | 800 |

| Диаметр присоед. труб, мм | 60 |

| Диаметр выходного патрубка, мм | 120 |

| Вес нетто, кг | 600 |

| Потребляемая мощность/напряжение, Вт/В | 275/220 |

| Объем воды в котле, л | 150 |

| Диаметр дымовой трубы, мм | 120 |

| Высота, мм | 1891 |

| Ширина, мм | 855 |

| Длина, мм |

Автоматические котлы «Прометей-Автомат»

Твердотопливные котлы длительного горения ПРОМЕТЕЙ™ Автомат. Имеют автоматическую подачу угля из бункера вместительностью до 5 м? (под заказ производиться бункер с увеличенным объемом) Мощность котлов от 40 до 1500 кВт.

Имеют автоматическую подачу угля из бункера вместительностью до 5 м? (под заказ производиться бункер с увеличенным объемом) Мощность котлов от 40 до 1500 кВт.

- 2

- 20

- 30

- 50

- Показать все

-

Быстрый просмотр

Автоматический котел ПРОМЕТЕЙ™ 40 Автоматический котел ПРОМЕТЕЙ™ 40

- org/Product» data-id=»1250″>

Быстрый просмотр

Автоматический котел ПРОМЕТЕЙ™ 80 Автоматический котел ПРОМЕТЕЙ™ 80

336 380 ₽

- org/Product» data-id=»1249″>

Быстрый просмотр

Автоматический котел ПРОМЕТЕЙ™ 140М Автоматический котел ПРОМЕТЕЙ™ 140М

603 340 ₽

- org/Product» data-id=»1231″>

Быстрый просмотр

Автоматический котел ПРОМЕТЕЙ™ 200М Автоматический котел ПРОМЕТЕЙ™ 200М

746 600 ₽

- org/Product» data-id=»1232″>

Автоматический котел ПРОМЕТЕЙ™ 300М Автоматический котел ПРОМЕТЕЙ™ 300М

818 930 ₽

- org/Product» data-id=»1233″>

Быстрый просмотр

Автоматический котел ПРОМЕТЕЙ™ 400М Автоматический котел ПРОМЕТЕЙ™ 400М

1 012 700 ₽

- org/Product» data-id=»1234″>

Быстрый просмотр

Автоматический котел ПРОМЕТЕЙ™ 600М Автоматический котел ПРОМЕТЕЙ™ 600М

1 449 000 ₽

- org/Product» data-id=»1235″>

Быстрый просмотр

Автоматический котел ПРОМЕТЕЙ™ 800М Автоматический котел ПРОМЕТЕЙ™ 800М

1 745 400 ₽

- org/Product» data-id=»1236″>

Быстрый просмотр

Автоматический котел ПРОМЕТЕЙ™ 1000М Автоматический котел ПРОМЕТЕЙ™ 1000М

2 031 300 ₽

- org/Product» data-id=»1237″>

Быстрый просмотр

Автоматический котел ПРОМЕТЕЙ™ 1500М Автоматический котел ПРОМЕТЕЙ™ 1500М

2 722 500 ₽

СанТехРесурс

У НАС СНОВА НОВИНОЧКИ!

08. 08.2019

08.2019

Новая мини-котельная уже в продаже!

06.06.2019

Все новости

Лучшая цена Хиты продаж Новинки

Водонагреватель ZANUSSI ZWH/S …

18 390 Р

В корзину

125157

Водонагреватель ZANUSSI ZWH/S 50 Splendore Dry

./images/cache/no_image-38×38.jpg

125157

18390.00

1

Водонагреватель ZANUSSI ZWH/S …

22 790 Р

В корзину

125158

Водонагреватель ZANUSSI ZWH/S 80 Splendore Dry

./images/cache/no_image-38×38.jpg

125158

22790.00

1

Водонагреватель эмал. бак Aris…

8 370 Р

В корзину

99327

Водонагреватель эмал. бак Ariston ABS ANDRIS LUX 10 UR, 1,2кВт, верх. подкл.

.

/images/cache/data/product/00000099327-38×38.jpg

/images/cache/data/product/00000099327-38×38.jpg99327

8370.00

1

Кран шаровой STC Solo ДУ-25 с …

508 Р

В корзину

6442

Кран шаровой STC Solo ДУ-25 с амер.

./images/cache/data/product/00000006442-38×38.jpg

6442

508.00

1

Фильтр на кран -09

899 Р

В корзину

100639

Фильтр на кран -09

./images/cache/data/product/00000100639-38×38.jpg

100639

899.00

1

Кран шаровой STC Solo ДУ-20 с …

337 Р

В корзину

6441

Кран шаровой STC Solo ДУ-20 с амер.

./images/cache/data/product/00000006441-38×38.jpg

6441

337.00

1

Кран шаровой латунный ДУ- 20 а.

..

..375 Р

В корзину

3472

Кран шаровой латунный ДУ- 20 американка /Галлоп

./images/cache/data/product/00000003472-38×38.jpg

3472

375.00

1

Радиатор биметалл. S19 BM 500/…

540 Р

В корзину

120345

Радиатор биметалл. S19 BM 500/78 120Вт Benarmo

./images/cache/no_image-38×38.jpg

120345

540.00

1

Сифон для умыв/мойки Was33 бут…

46 Р

В корзину

4324

Сифон для умыв/мойки Was33 бут 1 1/2 вып б/гофр отв/стир нерж/сетка

./images/cache/no_image-38×38.jpg

4324

46.00

1

Кран шаровой » BUGATTI» вн./на…

467 Р

В корзину

1230

Кран шаровой » BUGATTI» вн.

/нар. ДУ-20

/нар. ДУ-20./images/cache/data/product/00000001230-38×38.jpg

1230

467.00

1

Кран шаровой » BUGATTI» вн./вн…

592 Р

В корзину

1225

Кран шаровой » BUGATTI» вн./вн. ДУ-25

./images/cache/data/product/00000001225-38×38.jpg

1225

592.00

1

Сифон для умыв/мойки Was32 бут…

48 Р

В корзину

4323

Сифон для умыв/мойки Was32 бут 1 1/2 вып б/гофр нерж/сетка

./images/cache/no_image-38×38.jpg

4323

48.00

1

Насос скважинный центробежный …

11 350 Р

В корзину

113506

Насос скважинный центробежный PUMPMAN 4SM2-8F d100 0,37кВт H=48мQ=3,6м3 корп. и колеса нерж каб.

20м

20м./images/cache/data/product/00000113506-38×38.jpg

113506

11350.00

1

Радиатор биметалл. Ogint Ultra…

599 Р

В корзину

98316

Радиатор биметалл. Ogint Ultra Plus 500

./images/cache/data/product/00000098316-38×38.jpg

98316

599.00

1

Труба медная неотожженная SANC…

1 319 Р

В корзину

521

Труба медная неотожженная SANCO 22 ст.1 (пайка)

./images/cache/data/product/00000000521-38×38.jpg

521

1319.00

1

Кран шаровой » BUGATTI» с амер…

684 Р

В корзину

1232

Кран шаровой » BUGATTI» с американкой ДУ-20

./images/cache/data/product/00000001232-38×38.

jpg

jpg1232

684.00

1

Кран шаровой » BUGATTI» вн./вн…

304 Р

В корзину

1223

Кран шаровой » BUGATTI» вн./вн. ДУ-15

./images/cache/data/product/00000001223-38×38.jpg

1223

304.00

1

Кран шаровой » BUGATTI» вн./вн…

1 488 Р

В корзину

1227

Кран шаровой » BUGATTI» вн./вн. ДУ-40

./images/cache/data/product/00000001227-38×38.jpg

1227

1488.00

1

СИФОН для поддона WIRQUIN 11/2…

175 Р

В корзину

94633

СИФОН для поддона WIRQUIN 11/2*40

./images/cache/no_image-38×38.jpg

94633

175.00

1

Водосчетчик МЕТЕР СВ-15 монт.

…

…656 Р

В корзину

95071

Водосчетчик МЕТЕР СВ-15 монт. дл. 110мм , tmax=90C, поверка 6/6 лет г/х УЦЕНКА

./images/cache/data/product/00000095071-38×38.jpg

95071

656.00

1

Водосчетчик ЭКОМЕРА-15У монт….

689 Р

В корзину

97066

Водосчетчик ЭКОМЕРА-15У монт. дл. 110мм , tmax=90C, с кчм поверка 6/6 лет г/х

./images/cache/data/product/00000097066-38×38.jpg

97066

689.00

1

Насос скважинный центробежный …

20 305 Р

В корзину

113505

Насос скважинный центробежный PUMPMAN 4SM2-21F d100 1,5кВт H=126мQ=3,6м3 корп. и колеса нерж каб.40м

./images/cache/data/product/00000113505-38×38.jpg

113505

20305.00

1

Кран шаровой » BUGATTI» с амер.

..

..422 Р

В корзину

1231

Кран шаровой » BUGATTI» с американкой ДУ-15

./images/cache/data/product/00000001231-38×38.jpg

1231

422.00

1

Сифон для умыв/мойки Was 32A б…

35 Р

В корзину

4316

Сифон для умыв/мойки Was 32A бут 1 1/2 б/вып б/гофр

./images/cache/no_image-38×38.jpg

4316

35.00

1

Шланг душевой метал. рус/имп 1…

93 Р

В корзину

93605

Шланг душевой метал. рус/имп 1,5м

./images/cache/data/product/00000093605-38×38.jpg

93605

93.00

1

Кран шаровой » BUGATTI» с амер…

по запросу

В корзину

117170

Кран шаровой » BUGATTI» с американкой ДУ-20 626 арт.

ARIZONA

ARIZONA./images/cache/no_image-38×38.jpg

117170

1

Гофросифон Flexiplast

62 Р

В корзину

975

Гофросифон Flexiplast

./images/cache/no_image-38×38.jpg

975

62.00

1

Кран шаровой STC Solo ДУ-25 вн…

407 Р

В корзину

6433

Кран шаровой STC Solo ДУ-25 вн.-вн.

./images/cache/data/product/00000006433-38×38.jpg

6433

407.00

1

Понимание и использование шаблона многоцелевого экспортера

- Шаблон многоцелевого экспортера?

- Запуск многоцелевых экспортеров

- Базовый запрос многоцелевых экспортеров

- Настройка модулей

- Запрос многоцелевых экспортеров с помощью Prometheus

Это руководство познакомит вас с шаблоном многоцелевого экспортера. Для этого мы:

Для этого мы:

- опишем шаблон многоцелевого экспортера и почему он используется,

- запустить экспортер черного ящика в качестве примера шаблона,

- настроить пользовательский модуль запроса для экспортера черного ящика,

- разрешить экспортеру черного ящика выполнять базовые метрические запросы к веб-сайту Prometheus,

- изучить популярный шаблон настройки Prometheus для очистки экспортеров с использованием перемаркировки.

Шаблон многоцелевого экспортера?

Под шаблоном многоцелевого экспортера мы подразумеваем определенный дизайн, в котором:

- экспортер получит метрики цели по сетевому протоколу.

- экспортер не должен запускаться на машине, с которой берутся метрики.

- экспортер получает цели и строку конфигурации запроса в качестве параметров запроса GET Prometheus.

- экспортер впоследствии запускает очистку после получения GET-запросов Prometheus и после завершения очистки.

- экспортер может запрашивать несколько целей.

Этот шаблон используется только для определенных экспортеров, таких как черный ящик и экспортер SNMP.

Причина в том, что мы либо не можем запустить экспортер на цели, т.е. сетевое оборудование, говорящее по SNMP, или что нас явно интересует расстояние, например. задержка и доступность веб-сайта из определенной точки за пределами нашей сети, что является распространенным вариантом использования экспортера черного ящика.

Запуск многоцелевых экспортеров

Многоцелевые экспортеры гибки в отношении своей среды и могут запускаться разными способами. Как обычные программы, в контейнерах, как фоновые сервисы, на baremetal, на виртуальных машинах. Поскольку они опрашиваются и делают запросы по сети, им нужны соответствующие открытые порты. В противном случае они экономны.

Теперь давайте попробуем сами!

Используйте Docker для запуска контейнера экспортера черного ящика, запустив его в терминале. В зависимости от конфигурации вашей системы вам может потребоваться добавить команду

В зависимости от конфигурации вашей системы вам может потребоваться добавить команду sudo :

docker run -p 9115:9115 prom/blackbox-exporter

Вы должны увидеть несколько строк журнала, и если все прошло хорошо, последняя должна сообщить msg="Прослушивание адреса" , как показано здесь:

level=info ts=2018-10-17T15:41:35.4997596Z caller=main.go:324 msg="Прослушивание адреса" address=:9115

Основные запросы многоцелевых экспортеров

Есть два способа запроса:

- Запрос самого экспортера. У него есть свои метрики, обычно доступные по адресу

/metrics. - Запрос экспортера на очистку другой цели. Обычно доступно в «описательной» конечной точке, например.

/зонд. Вероятно, это то, что вас в первую очередь интересует при использовании многоцелевых экспортеров.

Вы можете вручную попробовать первый тип запроса с curl в другом терминале или использовать эту ссылку:

curl 'localhost:9115/metrics'

Ответ должен быть примерно таким:

# ПОМОЩЬ blackbox_exporter_build_info Метрика с постоянным значением '1', помеченная версией, ревизией, ветвью и версией, на основе которой был собран blackbox_exporter.# ТИП шкалы blackbox_exporter_build_info blackbox_exporter_build_info{branch="HEAD",goversion="go1.10",revision="4a22506cf0cf139"d9b2f9cde099f0012d9fcabde", версия = "0.12.0"} 1 # ПОМОЩЬ go_gc_duration_seconds Сводная информация о длительности вызовов сборщика мусора. # TYPE сводка go_gc_duration_seconds go_gc_duration_seconds{quantile="0"} 0 go_gc_duration_seconds{quantile="0,25"} 0 go_gc_duration_seconds{quantile="0,5"} 0 go_gc_duration_seconds{quantile="0,75"} 0 go_gc_duration_seconds{quantile="1"} 0 go_gc_duration_seconds_sum 0 go_gc_duration_seconds_count 0 # ПОМОЩЬ go_goroutines Количество существующих на данный момент горутин. # TYPE датчик go_goroutines go_goroutines 9[…] # ПОМОЩЬ process_cpu_seconds_total Общее время, затрачиваемое пользователем и системным процессором в секундах. # TYPE счетчик process_cpu_seconds_total process_cpu_seconds_total 0,05 # HELP process_max_fds Максимальное количество дескрипторов открытых файлов. # Датчик TYPE process_max_fds process_max_fds 1.048576e+06 # HELP process_open_fds Количество дескрипторов открытых файлов.

# Датчик TYPE process_open_fds process_open_fds 7 # ПОМОЩЬ process_resident_memory_bytes Размер резидентной памяти в байтах. # Индикатор TYPE process_resident_memory_bytes процесс_резидент_память_байт 7.8848e+06 # ПОМОЩЬ process_start_time_seconds Время начала процесса с эпохи unix в секундах. # Индикатор TYPE process_start_time_seconds process_start_time_seconds 1,541154e+09 # ПОМОЩЬ process_virtual_memory_bytes Размер виртуальной памяти в байтах. # Индикатор TYPE process_virtual_memory_bytes process_virtual_memory_bytes 1.5609856e+07

Это метрики в формате Prometheus. Они исходят от инструментов экспортера и сообщают нам о состоянии самого экспортера во время его работы. Это называется мониторингом белого ящика и очень полезно в повседневной практике. Если вам интересно, ознакомьтесь с нашим руководством по инструментированию собственных приложений.

Для второго типа запроса нам необходимо указать цель и модуль в качестве параметров в HTTP-запросе GET. Целью является URI или IP, а модуль должен быть определен в конфигурации экспортера. Контейнер экспортера черного ящика поставляется со значимой конфигурацией по умолчанию.

Контейнер экспортера черного ящика поставляется со значимой конфигурацией по умолчанию.

Мы будем использовать целевой prometheus.io и предопределенный модуль http_2xx . Он говорит экспортеру сделать запрос GET, как это сделал бы браузер, если бы вы перешли на prometheus.io и ожидать ответа 200 OK.

Теперь вы можете указать экспортеру черного ящика запросить prometheus.io в терминале с помощью curl:

curl 'localhost:9115/probe?target=prometheus.io&module=http_2xx'

Это вернет множество показателей:

# ПОМОЩЬ probe_dns_lookup_time_seconds Возвращает время, затраченное на поиск DNS зонда в секундах

# ТИП датчика probe_dns_lookup_time_seconds

probe_dns_lookup_time_seconds 0,061087943

# HELP probe_duration_seconds Возвращает время, которое потребовалось для завершения проверки в секундах.

# ТИП датчика probe_duration_seconds

probe_duration_seconds 0,065580871

# HELP probe_failed_due_to_regex Указывает, произошел ли сбой проверки из-за регулярного выражения

# ТИП датчика probe_failed_due_to_regex

probe_failed_due_to_regex 0

# HELP probe_http_content_length Длина ответа http-контента

# TYPE probe_http_content_length Gauge

probe_http_content_length 0

# HELP probe_http_duration_seconds Продолжительность http-запроса по фазам, суммированная по всем редиректам

# ТИП датчика probe_http_duration_seconds

probe_http_duration_seconds{фаза="подключение"} 0

probe_http_duration_seconds{phase="processing"} 0

probe_http_duration_seconds {фаза = "разрешить"} 0,061087943

probe_http_duration_seconds{phase="tls"} 0

probe_http_duration_seconds{phase="transfer"} 0

# ПОМОЩЬ probe_http_redirects Количество редиректов

# ТИП датчика probe_http_redirects

probe_http_redirects 0

# HELP probe_http_ssl Указывает, использовался ли SSL для окончательного перенаправления

# ТИП датчика probe_http_ssl

probe_http_ssl 0

# ПОМОЩЬ probe_http_status_code Код состояния ответа HTTP

# ТИП датчика probe_http_status_code

probe_http_status_code 0

# HELP probe_http_version Возвращает версию HTTP ответа зонда. # ТИП датчика probe_http_version

probe_http_version 0

# HELP probe_ip_protocol Указывает, является ли IP-протокол зонда IP4 или IP6.

# ТИП датчика probe_ip_protocol

probe_ip_protocol 6

# HELP probe_success Отображает успешность проверки.

# Датчик TYPE probe_success

probe_success 0

# ТИП датчика probe_http_version

probe_http_version 0

# HELP probe_ip_protocol Указывает, является ли IP-протокол зонда IP4 или IP6.

# ТИП датчика probe_ip_protocol

probe_ip_protocol 6

# HELP probe_success Отображает успешность проверки.

# Датчик TYPE probe_success

probe_success 0

Обратите внимание, что почти все показатели имеют значение 0 . Последний читает probe_success 0 . Это означает, что зонд не смог успешно связаться с prometheus.io . Причина скрыта в метрике probe_ip_protocol со значением 6 . По умолчанию зонд использует IPv6, пока не указано иное. Но демон Docker блокирует IPv6, пока не будет указано обратное. Следовательно, наш экспортер черного ящика, работающий в контейнере Docker, не может подключиться через IPv6.

Теперь мы можем либо указать Docker разрешить IPv6, либо экспортеру черного ящика использовать IPv4. В реальном мире и то, и другое может иметь смысл, и, как часто бывает, ответ на вопрос «что делать?» это «это зависит». Поскольку это руководство по экспортеру, мы изменим экспортер и воспользуемся возможностью настроить собственный модуль.

Поскольку это руководство по экспортеру, мы изменим экспортер и воспользуемся возможностью настроить собственный модуль.

Настройка модулей

Модули предварительно определены в файле внутри контейнера докеров с именем config.yml , который является копией blackbox.yml в репозитории github.

Мы скопируем этот файл, адаптируем его под свои нужды и скажем экспортеру использовать наш файл конфигурации вместо того, который включен в контейнер.

Сначала загрузите файл с помощью curl или браузера:

curl -o blackbox.yml https://raw.githubusercontent.com/prometheus/blackbox_exporter/master/blackbox.yml

Откройте его в редакторе. Первые несколько строк выглядят так:

модулей:

http_2xx:

зонд: http

http_post_2xx:

зонд: http

http:

метод: ПОСТ

YAML использует пробельные отступы для выражения иерархии, поэтому вы можете распознать, что определены два модуля с именами http_2xx и http_post_2xx , и что они оба имеют зонд http , и для одного значение метода специально установлено на ПОЧТ .

Теперь вы измените модуль http_2xx , установив предпочитаемый_ip_протокол зонда http явно на строку ip4 .

модули:

http_2xx:

зонд: http

http:

предпочтительный_ip_протокол: "ip4"

http_post_2xx:

зонд: http

http:

метод: ПОСТ

Если вы хотите узнать больше о доступных зондах и опциях, ознакомьтесь с документацией.

Теперь нам нужно указать экспортеру черного ящика использовать наш только что измененный файл. Вы можете сделать это с флагом --config.file="blackbox.yml" . Но поскольку мы используем Docker, мы сначала должны сделать этот файл доступным внутри контейнера с помощью --mount команда.

ПРИМЕЧАНИЕ. Если вы используете macOS, сначала необходимо разрешить демону Docker доступ к каталогу, в котором находится ваш blackbox.yml . Вы можете сделать это, нажав на маленького кита Docker в строке меню, а затем на Настройки -> Общий доступ к файлам -> + . После этого нажмите

После этого нажмите Применить и перезапустить .

Сначала вы останавливаете старый контейнер, переходя в его терминал и нажимая ctrl+c .

Убедитесь, что вы находитесь в каталоге, содержащем ваш blackbox.yml .

Затем вы запускаете эту команду. Длинно, но объясним:

docker\ запустить -p 9115:9115 \ --mount type=bind,source="$(pwd)"/blackbox.yml,target=/blackbox.yml,только для чтения \ пром/черный ящик-экспортер \ --config.file="/blackbox.yml"

С помощью этой команды вы сказали докеру :

-

запуститьконтейнер с портом9115вне контейнера, сопоставленным с портом9115внутри контейнера. -

смонтируйтеиз вашего текущего каталога ($(pwd)означает рабочий каталог для печати) файлblackbox.ymlв/blackbox.ymlв режиметолько для чтения. - используйте образ

prom/blackbox-exporterиз Docker Hub.

- запустить blackbox-exporter с флагом

--config.file, указав использовать/blackbox.ymlв качестве файла конфигурации.

Если все правильно, вы должны увидеть что-то вроде этого:

level=info ts=2018-10-19T12:40:51.650462756Z caller=main.go:213 msg="Starting blackbox_exporter" version="(version=0.12 .0, ветка = ГОЛОВА, ревизия = 4a22506cf0cf139d9b2f9cde099f0012d9fcabde)" level=info ts=2018-10-19T12:40:51.653357722Z caller=main.go:220 msg="Загружен файл конфигурации" level=info ts=2018-10-19T12:40:51.65349635Z caller=main.go:324 msg="Прослушивание адреса" address=:9115

Теперь вы можете попробовать наш новый модуль с использованием IPv4 http_2xx в терминале:

curl 'localhost:9115/probe?target=prometheus.io&module=http_2xx'

Что должно возвращать метрики Prometheus следующим образом:

# HELP probe_dns_lookup_time_seconds Возвращает время, затраченное на поиск DNS зонда в секундах # ТИП датчика probe_dns_lookup_time_seconds probe_dns_lookup_time_seconds 0,02679421 # HELP probe_duration_seconds Возвращает время, которое потребовалось для завершения проверки в секундах.# ТИП датчика probe_duration_seconds probe_duration_seconds 0,461619124 # HELP probe_failed_due_to_regex Указывает, произошел ли сбой проверки из-за регулярного выражения # ТИП датчика probe_failed_due_to_regex probe_failed_due_to_regex 0 # HELP probe_http_content_length Длина ответа http-контента # TYPE probe_http_content_length Gauge probe_http_content_length -1 # HELP probe_http_duration_seconds Продолжительность http-запроса по фазам, суммированная по всем редиректам # ТИП датчика probe_http_duration_seconds probe_http_duration_seconds{phase="connect"} 0,062076202999999996 probe_http_duration_seconds{phase="processing"} 0,23481845699999998 probe_http_duration_seconds{фаза="разрешить"} 0,0295

probe_http_duration_seconds{фаза="tls"} 0,163420078 probe_http_duration_seconds{phase="transfer"} 0,002243199 # ПОМОЩЬ probe_http_redirects Количество редиректов # ТИП датчика probe_http_redirects probe_http_redirects 1 # HELP probe_http_ssl Указывает, использовался ли SSL для окончательного перенаправления # ТИП датчика probe_http_ssl probe_http_ssl 1 # ПОМОЩЬ probe_http_status_code Код состояния ответа HTTP # ТИП датчика probe_http_status_code probe_http_status_code 200 # HELP probe_http_uncompressed_body_length Длина несжатого тела ответа # Датчик TYPE probe_http_uncompressed_body_length probe_http_uncompressed_body_length 14516 # HELP probe_http_version Возвращает версию HTTP ответа зонда.# ТИП датчика probe_http_version probe_http_version 1.1 # HELP probe_ip_protocol Указывает, является ли IP-протокол зонда IP4 или IP6. # ТИП датчика probe_ip_protocol probe_ip_protocol 4 # HELP probe_ssl_earliest_cert_expiry Возвращает самый ранний срок действия сертификата SSL в unixtime # ТИП датчика probe_ssl_earliest_cert_expiry probe_ssl_earliest_cert_expiry 1.581897599e+09 # HELP probe_success Отображает успешность проверки. # Датчик TYPE probe_success probe_success 1 # HELP probe_tls_version_info Содержит используемую версию TLS # ТИП датчика probe_tls_version_info probe_tls_version_info{версия="TLS 1.3"} 1

Вы можете видеть, что проверка прошла успешно, и получить множество полезных показателей, таких как задержка по фазам, код состояния, статус ssl или срок действия сертификата в Unix-времени.

Экспортер черного ящика также предлагает крошечный веб-интерфейс на localhost:9115, чтобы вы могли проверить последние несколько зондов, загруженную конфигурацию и информацию об отладке.Он даже предлагает прямую ссылку на зонд

prometheus.io. Удобно, если вам интересно, почему что-то не работает.Запрос многоцелевых экспортеров с помощью Prometheus

Пока все хорошо. Поздравьте себя. Экспортер черного ящика работает, и вы можете вручную указать ему запрашивать удаленную цель. Вы почти там. Теперь вам нужно сказать Prometheus, чтобы он выполнял запросы за нас.

Ниже вы найдете минимальную конфигурацию prometheus. Он говорит Prometheus очистить сам экспортер, как мы это делали до использования

curl 'localhost:9115/metrics':ПРИМЕЧАНИЕ. Если вы используете Docker для Mac или Docker для Windows, вы не можете использовать

localhost:9115в последней строке, но должны использоватьhost.docker .внутренний:9115. Это связано с виртуальными машинами, используемыми для реализации Docker в этих операционных системах. Вы не должны использовать это в производстве.

prometheus.ymlдля Linux:глобальный: скреб_интервал: 5 с scrape_configs: - job_name: blackbox # Чтобы получить метрики о самом экспортере путь_метрик: /метрики статические_конфигурации: - цели: - локальный: 9115

prometheus.ymlдля macOS и Windows:глобальный: скреб_интервал: 5 с scrape_configs: - job_name: blackbox # Чтобы получить метрики о самом экспортере путь_метрик: /метрики статические_конфигурации: - цели: - хост.докер.внутренний:9115Теперь запустите контейнер Prometheus и скажите ему смонтировать наш файл конфигурации сверху. Из-за того, что сеть на хосте адресуется из контейнера, вам нужно использовать немного другую команду в Linux, чем в MacOS и Windows:

Запустите Prometheus в Linux (не используйте

--network="host"в рабочей среде):docker \ запустить --network="хост"\ --mount type=bind,source="$(pwd)"/prometheus.yml,target=/prometheus.yml,только для чтения \ выпускной / прометей \ --config.file="/prometheus.yml"

Запустить Prometheus на MacOS и Windows:

docker \ запустить -p 9090:9090 \ --mount type=bind,source="$(pwd)"/prometheus.yml,target=/prometheus.yml,только для чтения \ выпускной / прометей \ --config.file="/prometheus.yml"Эта команда работает аналогично запуску экспортера черного ящика с использованием файла конфигурации.

Если все работает, вы сможете перейти на localhost:9090/targets и увидеть под черным ящиком

конечную точку с состояниемUPзеленым цветом. Если вы получаете красныйDOWN, убедитесь, что экспортер черного ящика, который вы запустили выше, все еще работает. Если вы не видите ничего или желтогоUNKNOWN, значит, вы работаете очень быстро, и вам нужно подождать еще несколько секунд, прежде чем перезагрузить вкладку браузера.Чтобы сообщить Prometheus о запросе

"localhost:9115/probe?target=prometheus., вы добавляете еще одно задание очисткиio&module=http_2xx"

blackbox-http, где вы устанавливаетеmetrics_pathна/probeи параметры нижеparams:в конфигурационном файле Prometheusprometheus.yml:global: скреб_интервал: 5 с scrape_configs: - job_name: blackbox # Чтобы получить метрики о самом экспортере путь_метрик: /метрики статические_конфигурации: - цели: - локальный: 9115 # Для Windows и macOS замените на - host.docker.internal:9115 - job_name: blackbox-http # Чтобы получить метрики о целях экспортера путь_метрики: /зонд параметры: модуль: [http_2xx] цель: [prometheus.io] статические_конфигурации: - цели: - localhost:9115 # Для Windows и macOS замените на - host.docker.internal:9115После сохранения файла конфигурации переключитесь на терминал с док-контейнером Prometheus и остановите его, нажав

ctrl+C, и снова запустите его, чтобы перезагрузить конфигурацию с помощью существующей команды.Терминал должен вернуть сообщение

«Сервер готов принимать веб-запросы».и через несколько секунд вы должны начать видеть красочные графики в своем Prometheus.Это работает, но имеет несколько недостатков:

- Фактические цели указываются в конфигурации параметров, что очень необычно и трудно для понимания позже.

- Метка

instanceимеет значение адреса экспортера черного ящика, что технически верно, но не то, что нас интересует.- Мы не можем увидеть, какой URL мы исследовали. Это непрактично, а также приведет к смешению разных метрик в одну, если мы проверим несколько URL-адресов.

Чтобы исправить это, мы будем использовать перемаркировку. Перемаркировка здесь полезна, потому что за кулисами многие вещи в Prometheus настраиваются с помощью внутренних меток. Детали сложны и выходят за рамки данного руководства. Поэтому ограничимся необходимым. Но если вы хотите узнать больше, посмотрите это выступление.

Пока достаточно, если вы понимаете это:

- Все этикетки, начинающиеся с

__, удаляются после очистки. Большинство внутренних меток начинаются с__. - Вы можете установить внутренние метки, которые называются

__param_. Те задают параметр URL с ключом<имя>для запроса очистки. - Существует внутренняя метка

__address__, которая устанавливаетсяцелямивstatic_configsи значением которой является имя хоста для запроса очистки. По умолчанию он позже используется для установки значения меткиinstance, который прикрепляется к каждой метрике и сообщает вам, откуда взялись метрики.

Вот конфигурация, которую вы будете использовать для этого. Не волнуйтесь, если это слишком много сразу, мы рассмотрим это шаг за шагом:

глобальный:

скреб_интервал: 5 с

scrape_configs:

- job_name: blackbox # Чтобы получить метрики о самом экспортере

путь_метрик: /метрики

статические_конфигурации:

- цели:

- localhost:9115 # Для Windows и macOS замените на - host. docker.internal:9115

- job_name: blackbox-http # Чтобы получить метрики о целях экспортера

путь_метрики: /зонд

параметры:

модуль: [http_2xx]

статические_конфигурации:

- цели:

- http://prometheus.io # Цель для проверки с http

- https://prometheus.io # Цель для проверки с помощью https

- http://example.com:8080 # Цель для проверки с http на порту 8080

relabel_configs:

- source_labels: [__адрес__]

target_label: __param_target

- source_labels: [__param_target]

target_label: экземпляр

- target_label: __адрес__

замена: локальный: 9115 # Настоящее имя хоста экспортера черного ящика: порт. Для Windows и macOS замените на - host.docker.internal:9115

docker.internal:9115

- job_name: blackbox-http # Чтобы получить метрики о целях экспортера

путь_метрики: /зонд

параметры:

модуль: [http_2xx]

статические_конфигурации:

- цели:

- http://prometheus.io # Цель для проверки с http

- https://prometheus.io # Цель для проверки с помощью https

- http://example.com:8080 # Цель для проверки с http на порту 8080

relabel_configs:

- source_labels: [__адрес__]

target_label: __param_target

- source_labels: [__param_target]

target_label: экземпляр

- target_label: __адрес__

замена: локальный: 9115 # Настоящее имя хоста экспортера черного ящика: порт. Для Windows и macOS замените на - host.docker.internal:9115

Так что нового по сравнению с последним конфигом?

params больше не включает цель . Вместо этого мы добавляем фактические цели в статические конфигурации : target . Мы также используем несколько, потому что мы можем сделать это сейчас:

params:

модуль: [http_2xx]

статические_конфигурации:

- цели:

- http://prometheus. io # Цель для проверки с http

- https://prometheus.io # Цель для проверки с помощью https

- http://example.com:8080 # Цель для проверки с http на порту 8080

io # Цель для проверки с http

- https://prometheus.io # Цель для проверки с помощью https

- http://example.com:8080 # Цель для проверки с http на порту 8080

relabel_configs содержит новые правила перемаркировки:

relabel_configs:

- source_labels: [__адрес__]

target_label: __param_target

- source_labels: [__param_target]

target_label: экземпляр

- target_label: __адрес__

замена: localhost:9115 # Настоящее имя хоста экспортера черного ящика: порт. Для Windows и macOS замените на - host.docker.internal:9115

До применения правил перемаркировки URI запроса Prometheus будет выглядеть следующим образом: "http://prometheus.io/probe?module=http_2xx" . После перемаркировки он будет выглядеть так: "http://localhost:9115/probe?target=http://prometheus.io&module=http_2xx" .

Теперь давайте рассмотрим, как это делает каждое правило:

Сначала мы берем значения из метки __address__ (которые содержат значения из целей ) и записываем их в новую метку __param_target , которая добавит параметр цель к запросам очистки Prometheus:

переназначить_конфигурации:

- source_labels: [__адрес__]

target_label: __param_target

После этого наш воображаемый URI запроса Prometheus теперь имеет целевой параметр: "http://prometheus. . io/probe?target=http://prometheus.io&module=http_2xx"

io/probe?target=http://prometheus.io&module=http_2xx"

Затем мы берем значения из метки __param_target и создаем экземпляр метки со значениями.

relabel_configs:

- source_labels: [__param_target]

target_label: экземпляр

Наш запрос не изменится, но метрики, которые возвращаются из нашего запроса, теперь будут иметь метку instance="http://prometheus.io" .

После этого записываем значение localhost:9115 (URI нашего экспортера) в метку __address__ . Это будет использоваться в качестве имени хоста и порта для запросов очистки Prometheus. Так что он напрямую запрашивает экспортер, а не целевой URI.

relabel_configs:

- target_label: __адрес__

замена: локальный: 9115 # Настоящее имя хоста экспортера черного ящика: порт. Для Windows и macOS замените на - host.docker.internal:9115

Теперь наш запрос "localhost:9115/probe?target=http://prometheus. . Таким образом, мы можем получить фактические цели, получить их как значения меток  io&module=http_2xx"

io&module=http_2xx" экземпляров , позволяя Prometheus сделать запрос к экспортеру черного ящика.

Часто люди объединяют их с обнаружением конкретной службы. Дополнительные сведения см. в документации по конфигурации. Использование их не проблема, так как они записывают в __address__ метка точно так же, как цели , определенные в static_configs .

Вот и все. Перезапустите док-контейнер Prometheus и посмотрите на свои показатели. Обратите внимание, что вы выбрали период времени, когда фактически собирались метрики.

В этом руководстве вы узнали, как работает шаблон многоцелевого экспортера, как запустить экспортер черного ящика с настроенным модулем и настроить Prometheus с использованием перемаркировки для извлечения метрик с помощью меток зонда.

Исходный код этой документации является открытым. Пожалуйста, помогите улучшить его, зарегистрировав проблемы или запросы на включение.

Блог | Прометей

Опубликовано: 16 ноября 2021 г., Бартломей Плотка (@bwplotka)Бартек Плотка работает мейнтейнером Prometheus с 2019 года и главным инженером-программистом в Red Hat. Соавтор проекта CNCF Thanos. Посол CNCF и технический руководитель CNCF TAG Observability. В свободное время он вместе с О'Рейли пишет книгу под названием «Эффективный подход». Мнения мои собственные!

Что мне лично нравится в проекте «Прометей» и одна из многих причин, по которым я присоединился к команде, так это четкий фокус на целях проекта. Prometheus всегда стремился раздвинуть границы, когда речь шла о предоставлении прагматичного, надежного, дешевого, но бесценного мониторинга на основе показателей. Сверхстабильные и надежные API-интерфейсы Prometheus, язык запросов и протоколы интеграции (например, Remote Write и OpenMetrics) позволили экосистеме метрик Cloud Native Computing Foundation (CNCF) расти на этих прочных основаниях. В результате произошли удивительные вещи:

- Мы видим, что экспортеры сообщества получают метрики практически обо всем, например.

контейнеры, eBPF, статистика сервера Minecraft и даже здоровье растений при работе в саду.

контейнеры, eBPF, статистика сервера Minecraft и даже здоровье растений при работе в саду. - Большинство людей в настоящее время ожидают, что облачное программное обеспечение будет иметь конечную точку HTTP/HTTPS

/metrics, которую Prometheus может очищать. Концепция, тайно разработанная в Google и впервые реализованная во всем мире в рамках проекта Prometheus. - Парадигма наблюдаемости изменилась. Мы видим, что SRE и разработчики в значительной степени полагаются на метрики с первого дня, что повышает отказоустойчивость программного обеспечения, возможность отладки и принятие решений на основе данных!

В конце концов, мы вряд ли увидим кластеры Kubernetes без работающего там Prometheus.

Сильная направленность сообщества Prometheus позволила другим проектам с открытым исходным кодом также расти, чтобы расширить модель развертывания Prometheus за пределы отдельных узлов (например, Cortex, Thanos и другие). Не говоря уже о поставщиках облачных услуг, использующих API и модель данных Prometheus (например, Amazon Managed Prometheus, Google Cloud Managed Prometheus, Grafana Cloud и другие). Если вы ищете единственную причину успеха проекта «Прометей», то вот она: Сосредоточение внимания сообщества наблюдателей на том, что важно .

Если вы ищете единственную причину успеха проекта «Прометей», то вот она: Сосредоточение внимания сообщества наблюдателей на том, что важно .

В этом (длинном) сообщении блога я хотел бы представить новый режим работы Prometheus под названием «Агент». Он встроен непосредственно в бинарный файл Prometheus. Режим агента отключает некоторые обычные функции Prometheus и оптимизирует двоичный файл для очистки и удаленной записи в удаленные места. Внедрение режима, который сокращает количество функций, позволяет использовать новые модели использования. В этом сообщении в блоге я объясню, почему это меняет правила игры для некоторых развертываний в экосистеме CNCF. Я очень взволнован этим!

История варианта использования переадресации

Основная конструкция Прометея не менялась на протяжении всей жизни проекта. Вдохновленный системой мониторинга Google Borgmon, вы можете развернуть сервер Prometheus вместе с приложениями, которые вы хотите отслеживать, сообщить Prometheus, как к ним добраться, и разрешить собирать текущие значения их показателей через регулярные промежутки времени. Такой метод сбора, который часто называют «моделью вытягивания», является основным принципом, который позволяет Prometheus быть легким и надежным. Кроме того, это позволяет максимально упростить инструментирование приложений и экспортеров, поскольку им нужно только предоставить простую удобочитаемую конечную точку HTTP с текущим значением всех отслеживаемых показателей (в формате OpenMetrics). И все это без сложной push-инфраструктуры и нетривиальных клиентских библиотек. В целом упрощенное типичное развертывание мониторинга Prometheus выглядит следующим образом:

Такой метод сбора, который часто называют «моделью вытягивания», является основным принципом, который позволяет Prometheus быть легким и надежным. Кроме того, это позволяет максимально упростить инструментирование приложений и экспортеров, поскольку им нужно только предоставить простую удобочитаемую конечную точку HTTP с текущим значением всех отслеживаемых показателей (в формате OpenMetrics). И все это без сложной push-инфраструктуры и нетривиальных клиентских библиотек. В целом упрощенное типичное развертывание мониторинга Prometheus выглядит следующим образом:

Это прекрасно работает, и мы видели миллионы успешных развертываний, подобных этому, которые обрабатывают десятки миллионов активных серий. Некоторые из них предназначены для более длительного хранения, например, два года или около того. Все они позволяют запрашивать, предупреждать и записывать метрики, полезные как для администраторов кластера, так и для разработчиков.

Однако облачный мир постоянно растет и развивается. С ростом количества управляемых решений Kubernetes и кластеров, создаваемых по запросу за считанные секунды, мы наконец-то можем относиться к кластерам как к «скоту», а не как к «домашним животным» (другими словами, мы меньше заботимся об отдельных их экземплярах). В некоторых случаях решения даже не имеют понятия кластера, например. kcp, Fargate и другие платформы.

С ростом количества управляемых решений Kubernetes и кластеров, создаваемых по запросу за считанные секунды, мы наконец-то можем относиться к кластерам как к «скоту», а не как к «домашним животным» (другими словами, мы меньше заботимся об отдельных их экземплярах). В некоторых случаях решения даже не имеют понятия кластера, например. kcp, Fargate и другие платформы.

Другим интересным вариантом использования является понятие кластеров или сетей Edge . В таких отраслях, как телекоммуникации, автомобилестроение и устройства IoT, использующих облачные технологии, мы видим все больше и больше кластеров гораздо меньшего размера с ограниченным объемом ресурсов. Это вынуждает передавать все данные (включая наблюдаемость) удаленным, более крупным аналогам, поскольку на этих удаленных узлах почти ничего не может храниться.

Что это значит? Это означает, что данные мониторинга должны быть каким-то образом агрегированы, представлены пользователям, а иногда даже сохранены в глобальный уровень . Это часто называют функцией Global-View .

Это часто называют функцией Global-View .

Наивно, мы могли подумать о реализации этого, либо поместив Prometheus на этот глобальный уровень и собирая метрики по удаленным сетям, либо отправляя метрики непосредственно из приложения в центральное расположение для целей мониторинга. Позвольте мне объяснить, почему обе идеи, как правило, очень плохие идеи:

🔥 Очистка границ сети может быть сложной задачей, если она добавляет новые неизвестные в конвейер мониторинга. Модель локального вытягивания позволяет Prometheus узнать, почему именно у целевой метрики возникают проблемы и когда. Возможно, он не работает, неправильно настроен, перезапущен, слишком медленный, чтобы предоставить нам метрики (например, загруженность ЦП), не может быть обнаружен с помощью обнаружения служб, у нас нет учетных данных для доступа или просто DNS, сеть или весь кластер не работает. Помещая наш парсер за пределы сети, мы рискуем потерять часть этой информации, внося ненадежность в парсер, не связанный с отдельной целью. Кроме того, мы рискуем полностью потерять важную видимость, если сеть временно не работает. Пожалуйста, не делай этого. Это того не стоит. (:

Кроме того, мы рискуем полностью потерять важную видимость, если сеть временно не работает. Пожалуйста, не делай этого. Это того не стоит. (:

🔥 Передавать метрики напрямую из приложения в какое-то центральное место тоже плохо. Особенно когда вы контролируете большой парк, вы буквально ничего не знаете, когда не видите метрики из удаленных приложений. Приложение не работает? Мой ресивер не работает? Может приложение не авторизовалось? Может быть, ему не удалось получить IP-адрес моего удаленного кластера? Может быть, это слишком медленно? Может сеть глючит? Хуже того, вы можете даже не знать, что данные некоторых целевых приложений отсутствуют. И вы даже не получите многого, поскольку вам нужно отслеживать состояние и статус всего, что должно отправлять данные. Такой дизайн требует тщательного анализа, поскольку он может слишком легко привести к провалу.

ПРИМЕЧАНИЕ. Бессерверные функции и недолговечные контейнеры часто являются теми случаями, когда мы рассматриваем отправку из приложения как спасение.

Однако на этом этапе мы говорим о событиях или фрагментах метрик, которые мы, возможно, захотим объединить в более долгосрочные временные ряды. Эта тема обсуждается здесь, не стесняйтесь вносить свой вклад и помогать нам лучше поддерживать эти дела!

Prometheus представил три способа поддержки случая глобального просмотра, каждый со своими плюсами и минусами. Кратко пройдемся по ним. На схеме ниже они показаны оранжевым цветом:

- Федерация была представлена как первая функция для целей агрегирования. Это позволяет серверу Prometheus глобального уровня очищать подмножество метрик от листа Prometheus. Такая «федеративная» очистка уменьшает количество неизвестных в сетях, поскольку метрики, предоставляемые конечными точками федерации, включают временные метки исходных образцов. Тем не менее, он обычно страдает от невозможности объединить все метрики и не потерять данные во время более длинных сетевых разделов (минут).

- Prometheus Remote Read позволяет выбирать необработанные метрики из базы данных удаленного сервера Prometheus без прямого запроса PromQL.

Вы можете развернуть Prometheus или другие решения (например, Thanos) на глобальном уровне, чтобы выполнять запросы PromQL к этим данным, получая необходимые метрики из нескольких удаленных мест. Это действительно мощно, поскольку позволяет хранить данные «локально» и получать к ним доступ только при необходимости. К сожалению, есть и минусы. Без таких функций, как Query Pushdown, мы в крайних случаях извлекаем ГБ сжатых данных метрик для ответа на один запрос. Кроме того, если у нас есть сетевой раздел, мы временно слепы. И последнее, но не менее важное: некоторые правила безопасности не разрешают входящий трафик, а разрешают только исходящий.

Вы можете развернуть Prometheus или другие решения (например, Thanos) на глобальном уровне, чтобы выполнять запросы PromQL к этим данным, получая необходимые метрики из нескольких удаленных мест. Это действительно мощно, поскольку позволяет хранить данные «локально» и получать к ним доступ только при необходимости. К сожалению, есть и минусы. Без таких функций, как Query Pushdown, мы в крайних случаях извлекаем ГБ сжатых данных метрик для ответа на один запрос. Кроме того, если у нас есть сетевой раздел, мы временно слепы. И последнее, но не менее важное: некоторые правила безопасности не разрешают входящий трафик, а разрешают только исходящий. - Наконец, у нас есть Prometheus Remote Write , который кажется самым популярным выбором в настоящее время. Поскольку режим агента ориентирован на варианты использования удаленной записи, давайте объясним его более подробно.

Удаленная запись

Протокол удаленной записи Prometheus позволяет нам пересылать (поток) все или часть метрик, собранных Prometheus, в удаленное место. Вы можете настроить Prometheus для пересылки некоторых метрик (если хотите, со всеми метаданными и экземплярами!) в одно или несколько мест, которые поддерживают API удаленной записи. Фактически, Prometheus поддерживает как получение, так и отправку удаленной записи, поэтому вы можете развернуть Prometheus на глобальном уровне для получения этого потока и агрегирования данных между кластерами.

Вы можете настроить Prometheus для пересылки некоторых метрик (если хотите, со всеми метаданными и экземплярами!) в одно или несколько мест, которые поддерживают API удаленной записи. Фактически, Prometheus поддерживает как получение, так и отправку удаленной записи, поэтому вы можете развернуть Prometheus на глобальном уровне для получения этого потока и агрегирования данных между кластерами.

Хотя официальная спецификация Prometheus Remote Write API находится на стадии рассмотрения, экосистема приняла протокол удаленной записи в качестве протокола экспорта метрик по умолчанию. Например, Cortex, Thanos, OpenTelemetry и облачные сервисы, такие как Amazon, Google, Grafana, Logz.io и т. д., поддерживают прием данных через удаленную запись.

Проект Prometheus также предлагает официальные тесты на соответствие для своих API, например. соответствие отправителю удаленной записи для решений, предлагающих возможности клиента удаленной записи. Это отличный способ быстро определить, правильно ли вы реализуете этот протокол.

Потоковая передача данных из такого парсера позволяет использовать варианты использования Global View, позволяя хранить данные метрик в централизованном расположении. Это также позволяет разделить задачи, что полезно, когда приложения управляются другими командами, а не конвейерами наблюдения или мониторинга. Кроме того, именно поэтому Remote Write выбирают поставщики, которые хотят снять с клиентов как можно больше работы.

Подожди секунду, Бартек. Вы только что упомянули, что загружать метрики напрямую из приложения — не лучшая идея!

Конечно, но самое удивительное то, что даже с удаленной записью Prometheus по-прежнему использует модель извлечения для сбора метрик из приложений, что дает нам представление об этих различных режимах отказа. После этого мы группируем образцы и серии и экспортируем, реплицируем (проталкиваем) данные на конечные точки удаленной записи, ограничивая количество неизвестных данных мониторинга, которые есть в центральной точке!

Важно отметить, что надежная и эффективная реализация удаленной записи — это нетривиальная задача. Сообщество Prometheus потратило около трех лет на разработку стабильной и масштабируемой реализации. Мы несколько раз повторно реализовали WAL (журнал с упреждающей записью), добавили внутренние очереди, сегментирование, интеллектуальные отсрочки и многое другое. Все это скрыто от пользователя, который может наслаждаться высокопроизводительной потоковой передачей или большим количеством метрик, хранящихся в централизованном месте.

Сообщество Prometheus потратило около трех лет на разработку стабильной и масштабируемой реализации. Мы несколько раз повторно реализовали WAL (журнал с упреждающей записью), добавили внутренние очереди, сегментирование, интеллектуальные отсрочки и многое другое. Все это скрыто от пользователя, который может наслаждаться высокопроизводительной потоковой передачей или большим количеством метрик, хранящихся в централизованном месте.

Практический пример удаленной записи: учебное пособие по Katacoda

Все это не ново для Прометея. Многие из нас уже используют Prometheus для очистки всех необходимых метрик и удаленной записи всех или некоторых из них в удаленные места.

Предположим, вы хотите попробовать на практике возможности удаленного письма. В этом случае мы рекомендуем руководство Thanos Katacoda по удаленному написанию метрик из Prometheus, в котором объясняются все шаги, необходимые Prometheus для пересылки всех метрик в удаленное место. это бесплатно , просто зарегистрируйте учетную запись и наслаждайтесь уроком! 🤗

Обратите внимание, что в этом примере в качестве удаленного хранилища используется Thanos в режиме приема. В настоящее время вы можете использовать множество других проектов, совместимых с API удаленной записи.

В настоящее время вы можете использовать множество других проектов, совместимых с API удаленной записи.

Итак, если удаленная запись работает нормально, зачем мы добавили в Prometheus специальный режим Агента?

Режим агента Прометея

Из Prometheus v2.32.0 (следующий релиз) каждый сможет запустить бинарник Prometheus с экспериментальной --enable-feature=флаг агента . Если вы хотите попробовать его до выпуска, не стесняйтесь использовать Prometheus v2.32.0-beta.0 или наш образ quay.io/prometheus/prometheus:v2.32.0-beta.0 .

Режим агента оптимизирует Prometheus для варианта использования удаленной записи. Он отключает запросы, оповещения и локальное хранилище и заменяет их настраиваемой TSDB WAL. Все остальное остается прежним: логика парсинга, обнаружение сервисов и соответствующая конфигурация. Его можно использовать в качестве замены Prometheus, если вы хотите просто переслать свои данные на удаленный сервер Prometheus или в любой другой проект, совместимый с Remote-Write. По сути это выглядит так:

По сути это выглядит так:

Лучшее в Prometheus Agent то, что он встроен в Prometheus. Те же API парсинга, та же семантика, та же конфигурация и механизм обнаружения.

Каковы преимущества использования режима агента, если вы планируете не запрашивать данные и не оповещать о них локально, а передавать метрики извне? Есть несколько:

В первую очередь эффективность. Наш настроенный агент TSDB WAL удаляет данные сразу после успешной записи. Если он не может связаться с удаленной конечной точкой, он временно сохраняет данные на диске до тех пор, пока удаленная конечная точка не вернется в оперативный режим. В настоящее время это ограничено только двухчасовым буфером, подобно Прометею без агента, который, надеюсь, скоро будет разблокирован. Это означает, что нам не нужно создавать блоки данных в памяти. Нам не нужно поддерживать полный индекс для запросов. По сути, режим агента использует часть ресурсов, которые обычный сервер Prometheus использовал бы в аналогичной ситуации.

Имеет ли значение эта эффективность? Да! Как мы уже упоминали, каждый ГБ памяти и каждое ядро ЦП, используемое в пограничных кластерах, имеет значение для некоторых развертываний. С другой стороны, парадигма выполнения мониторинга с использованием метрик в наши дни достаточно зрелая. Это означает, что чем более релевантные метрики с большей кардинальностью вы можете отправить по той же цене, тем лучше.

ПРИМЕЧАНИЕ. С введением режима агента исходный режим сервера Prometheus по-прежнему остается рекомендуемым, стабильным и поддерживаемым режимом. Агентский режим с удаленным хранилищем создает дополнительную сложность. Используйте с осторожностью.

Во-вторых, преимущество нового режима агента заключается в том, что он упрощает горизонтальную масштабируемость для приема данных. Это то, чем я взволнован больше всего. Позвольте мне объяснить, почему.

Мечта: Автоматически масштабируемый прием метрик

Настоящее автоматически масштабируемое решение для парсинга должно основываться на количестве целевых метрик и количестве метрик, которые они предоставляют. Чем больше данных мы собираем, тем больше экземпляров Prometheus мы развертываем автоматически. Если количество целей или их метрик уменьшится, мы можем уменьшить масштаб и удалить пару экземпляров. Это устранит бремя ручной настройки размера Prometheus и избавит от необходимости чрезмерно выделять Prometheus для ситуаций, когда кластер временно мал.

Чем больше данных мы собираем, тем больше экземпляров Prometheus мы развертываем автоматически. Если количество целей или их метрик уменьшится, мы можем уменьшить масштаб и удалить пару экземпляров. Это устранит бремя ручной настройки размера Prometheus и избавит от необходимости чрезмерно выделять Prometheus для ситуаций, когда кластер временно мал.

Когда Prometheus работал в режиме сервера, этого было трудно добиться. Это связано с тем, что Prometheus в режиме сервера сохраняет состояние. Все, что собрано, остается как есть в одном месте. Это означает, что перед прекращением процедуры масштабирования потребуется выполнить резервное копирование собранных данных в существующие экземпляры. Тогда у нас возникнет проблема перекрывающихся царапин, вводящих в заблуждение маркеров устаревания и т. д.

Кроме того, нам понадобится какой-нибудь запрос глобального представления, способный агрегировать все выборки во всех экземплярах (например, Thanos Query или Promxy). И последнее, но не менее важное: использование ресурсов Prometheus в режиме сервера зависит не только от приема. Предупреждения, запись, запросы, уплотнение, удаленная запись и т. д. могут потребовать больше или меньше ресурсов, независимо от количества целевых показателей.

Предупреждения, запись, запросы, уплотнение, удаленная запись и т. д. могут потребовать больше или меньше ресурсов, независимо от количества целевых показателей.

Режим агента по существу перемещает обнаружение, очистку и удаленную запись в отдельную микрослужбу. Это позволяет сфокусировать операционную модель только на приеме пищи. В результате Prometheus в режиме агента более или менее не имеет состояния. Да, чтобы избежать потери метрик, нам нужно развернуть пару агентов HA и подключить к ним постоянный диск. Но с технической точки зрения, если у нас есть тысячи метрических целей (например, контейнеров), мы можем развернуть несколько агентов Prometheus и безопасно изменить, какая реплика очищает какие цели. Это связано с тем, что, в конце концов, все образцы будут помещены в одно и то же центральное хранилище.

В целом, Prometheus в режиме агента обеспечивает простые горизонтальные возможности автоматического масштабирования парсинга на основе Prometheus, которые могут реагировать на динамические изменения целевых показателей. Это определенно то, на что мы будем обращать внимание в сообществе Prometheus Kubernetes Operator в будущем.

Это определенно то, на что мы будем обращать внимание в сообществе Prometheus Kubernetes Operator в будущем.

Теперь давайте посмотрим на текущее состояние режима агента в Prometheus. Готов ли он к использованию?

Режим агента был проверен в масштабе

Следующий выпуск Prometheus будет включать режим агента в качестве экспериментальной функции. Флаги, API и формат WAL на диске могут измениться. Но производительность реализации уже проверена в бою благодаря работе Grafana Labs с открытым исходным кодом.

Первоначальная реализация пользовательского WAL нашего агента была вдохновлена текущим WAL TSDB сервера Prometheus и создана Робертом Фратто в 2019 году под руководством Тома Уилки, сопровождающего Prometheus. Затем он использовался в проекте Grafana Agent с открытым исходным кодом, который с тех пор использовался многими клиентами Grafana Cloud и членами сообщества. Учитывая зрелость решения, пришло время пожертвовать реализацию Prometheus для нативной интеграции и более широкого внедрения. Роберт (Grafana Labs) с помощью Шрикришны (Red Hat) и сообщества перенес код в кодовую базу Prometheus, которая была объединена с

Роберт (Grafana Labs) с помощью Шрикришны (Red Hat) и сообщества перенес код в кодовую базу Prometheus, которая была объединена с главная 2 недели назад!

Процесс пожертвования прошел довольно гладко. Поскольку некоторые сопровождающие Prometheus ранее вносили свой вклад в этот код в рамках агента Grafana, и поскольку новый WAL вдохновлен собственным WAL Prometheus, текущим сопровождающим Prometheus TSDB не составило труда взять его на полное обслуживание! Также очень помогает то, что Роберт присоединяется к команде Prometheus в качестве сопровождающего TSDB (поздравляем!).

А теперь давайте объясним, как им пользоваться! (:

Подробное описание использования режима агента

С этого момента, если вы покажете вывод справки Prometheus (флаг --help ), вы должны увидеть примерно следующее:

использование: прометей [] Сервер мониторинга Prometheus Флаги: -h, --help Показать контекстно-зависимую справку (также попробуйте --help-long и --help-man). (... другие флаги) --storage.tsdb.path="данные/" Базовый путь для хранения метрик. Используйте только в режиме сервера. --storage.agent.path="агент данных/" Базовый путь для хранения метрик. Использовать только в режиме агента. (... другие флаги) --enable-feature= ... Имена функций, разделенные запятыми, для включения. Допустимые параметры: агент, экземпляр-хранилище, расширение-внешние-метки, моментальный снимок-памяти-при-выключении, promql-at-modifier, promql-negative-offset, удаленный-запись-приемник, дополнительные метрики очистки, менеджер по обнаружению новых услуг. Подробнее см. https://prometheus.io/docs/prometheus/latest/feature_flags/.

Поскольку режим агента находится за флагом функции, как упоминалось ранее, используйте флаг --enable-feature=agent для запуска Prometheus в режиме агента. Теперь остальные флаги либо для сервера, либо для агента, либо только для определенного режима. Вы можете увидеть, какой флаг для какого режима, проверив последнее предложение строки справки флага. «Использовать только в режиме сервера» означает, что это только для режима сервера. Если вы не видите подобного упоминания, это означает, что флаг используется совместно.

Вы можете увидеть, какой флаг для какого режима, проверив последнее предложение строки справки флага. «Использовать только в режиме сервера» означает, что это только для режима сервера. Если вы не видите подобного упоминания, это означает, что флаг используется совместно.

Режим агента принимает ту же конфигурацию очистки с теми же параметрами обнаружения и удаленной записи.

Он также предоставляет веб-интерфейс с отключенными возможностями запросов, но показывает информацию о сборке, конфигурации, целях и информации об обнаружении служб, как на обычном сервере Prometheus.

Практический пример агента Prometheus: руководство по Katacoda

Аналогично учебному пособию по удаленной записи Prometheus, если вы хотите попробовать на практике возможности агента Prometheus, мы рекомендуем учебное пособие Thanos Katacoda для агента Prometheus, в котором объясняется, насколько просто запустить агент Prometheus.

Резюме

Надеюсь, вам было интересно! В этом посте мы рассмотрели новые случаи, которые появились, например:

.

- пограничные кластеры

- сети с ограниченным доступом

- большое количество кластеров

- эфемерные и динамические кластеры

Затем мы объяснили новый режим агента Prometheus, который позволяет эффективно пересылать очищенные метрики на удаленные конечные точки записи.

Как всегда, если у вас есть какие-либо вопросы или отзывы, не стесняйтесь отправить заявку на GitHub или задать вопросы в списке рассылки.

Опубликовано: 14 октября 2021 г. Ричардом «RichiH» ХартманномЭтот пост в блоге является частью согласованного выпуска между CNCF, Grafana и Prometheus. Не стесняйтесь также читать объявление CNCF и взгляд на агента Grafana, который лежит в основе агента Prometheus.

Сегодня мы запускаем программу соответствия Prometheus с целью обеспечения взаимодействия между различными проектами и поставщиками в пространстве мониторинга Prometheus. В то время как юридические документы все еще нуждаются в доработке, мы провели тесты и считаем, что ниже наш первый раунд результатов. В рамках этого запуска Юлиус Волц обновил результаты своего теста PromQL.

В рамках этого запуска Юлиус Волц обновил результаты своего теста PromQL.

В качестве краткого напоминания: программа называется Prometheus Conformance , программное обеспечение может быть совместимым для конкретных тестов, что приводит к рейтингу совместимости . Номенклатура может показаться сложной, но она позволяет нам говорить на эту тему, не используя бесконечные словесные змеи.

- Новые категории

- Призыв к действию

- Зарегистрироваться для тестирования

- Полная совместимость с Прометеем

- Проекты

- ААС

- Агент/Сборщик

- Прохождение

- Не проходит

новых категорий

Мы обнаружили, что довольно сложно рассуждать о том, что нужно применять к какому программному обеспечению. Чтобы помочь разобраться в моих мыслях, мы создали обзор, в котором представлены четыре новые категории, в которые мы можем поместить программное обеспечение:

.

- Показатели показателей

- Агенты/Коллекционеры

- Серверные части хранилища Prometheus

- Полная совместимость с Прометеем

Призыв к действию

Обратная связь очень приветствуется. Возможно, вопреки интуиции, мы хотим, чтобы сообщество, а не только команда Prometheus, формировало эти усилия. Чтобы помочь с этим, мы запустим WG Conformance в Prometheus. Как и в случае с WG Docs и WG Storage, они будут общедоступными, и мы активно приглашаем к участию.

Как мы недавно упоминали, соотношение тех, кто поддерживает Prometheus, и тех, кто принимает его, на удивление или шокирующе низкое. Другими словами, мы надеемся, что экономические стимулы, связанные с совместимостью Prometheus, побудят поставщиков выделять ресурсы для создания тестов вместе с нами. Если вы всегда хотели внести свой вклад в Prometheus в рабочее время, это может быть подходящим способом; и способ, который заставит вас коснуться многих очень важных аспектов Прометея. Связаться с нами можно разными способами.

Связаться с нами можно разными способами.

Зарегистрироваться для тестирования

Вы можете использовать те же каналы связи, чтобы связаться с нами, если хотите зарегистрироваться для прохождения тестирования. Как только документы будут готовы, мы передадим контактную информацию и договорные операции в CNCF.

Полная совместимость с Prometheus

Мы знаем, какие тесты мы хотим построить, но мы еще не готовы. Как было объявлено ранее, было бы несправедливо обвинять в этом проекты или поставщиков. Таким образом, тестовые прокладки считаются пройденными. В настоящее время полуручной характер, например. Тесты PromQL, проведенные Julius на этой неделе, означают, что Julius тестировал отправку данных через Prometheus Remote Write в большинстве случаев как часть тестирования PromQL. Мы повторно используем его результаты более чем одним способом. Скоро это будет распутано, и больше тестов с разных точек зрения будет продолжать повышать требования и, следовательно, доверие конечного пользователя.

Имеет смысл рассматривать проекты и предложения как услугу в двух наборах.

проектов

Прохождение

- Кортекс 1.10.0

- М3 1.3.0

- Промышленная шкала 0.6.2

- Танос 0.23.1

Не проходит

VictoriaMetrics 1.67.0 не проходит и не собирается проходить. В духе доверия конечных пользователей мы решили отслеживать их результаты, пока они позиционируют себя как замену Prometheus.

ААС

Прохождение

- Хроносфера

- Графана Облако

Не проходит

- Управляемая служба Amazon для Prometheus

- Облачная управляемая служба Google для Prometheus

- Новая реликвия

- Системный монитор

NB. Поскольку Amazon Managed Service для Prometheus основан на Cortex, как и Grafana Cloud, мы ожидаем, что они перейдут после следующего цикла обновления.

Агент/Коллекционер

Прохождение

- Агент Графана 0.

19.0

19.0 - Сборщик OpenTelemetry 0.37.0

- Прометей 2.30.3

Не проходит

- Телеграф 1.20.2

- Древесина Вектор 0.16.1

- Агент VictoriaMetrics 1.67.0

NB: мы тестировали Vector 0.16.1 вместо 0.17.0, потому что для 0.17.0 нет бинарных загрузок, а наша тестовая цепочка инструментов в настоящее время ожидает бинарные файлы.

Опубликовано: 10 июня 2021 г. Ричардом «RichiH» ХартманномСогласно Оскару Уайльду, подражание — самая искренняя форма лести.

Имена «Прометей» и «Танос» недавно были присвоены группой вымогателей. Мы мало что можем с этим сделать, кроме как сообщить вам, что это происходит. Вы тоже мало что можете сделать, кроме как знать, что это происходит.

Хотя у нас НЕ есть основания полагать, что эта группа попытается обманом заставить кого-либо загрузить поддельные двоичные файлы наших проектов, мы по-прежнему рекомендуем следовать общепринятым методам цепочки поставок и безопасности. При развертывании программного обеспечения делайте это с помощью одного из следующих механизмов:

При развертывании программного обеспечения делайте это с помощью одного из следующих механизмов:

- Бинарные загрузки с официальных страниц релизов Prometheus и Thanos с проверкой контрольных сумм.

- загрузки Docker из официальных репозиториев, контролируемых проектом:

- Прометей: https://quay.io/repository/prometheus/prometheus и https://hub.docker.com/r/prom/prometheus

- Танос: https://quay.io/repository/thanos/thanos и https://hub.docker.com/r/thanosio/thanos

- Двоичные файлы, образы или контейнеры из дистрибутивов, которым вы доверяете

- Двоичные файлы, образы или контейнеры из ваших собственных внутренних групп проверки и развертывания программного обеспечения

- Самостоятельная сборка из исходников

Если вы не можете разумно доверять конкретному провидению и цепочке поставок, вам не следует использовать программное обеспечение.

Поскольку существует ненулевая вероятность того, что группа вымогателей намеренно выбрала имена и, таким образом, может наткнуться на это сообщение в блоге: пожалуйста, остановитесь. Как с программой-вымогателем, так и с выбором имени.

Как с программой-вымогателем, так и с выбором имени.

Как было объявлено CNCF и нами, мы запускаем программу соответствия Prometheus.

Чтобы дать всем представление о состоянии экосистемы перед официальным запуском тестов, мы хотели продемонстрировать новейшее дополнение к нашему небольшому набору тестовых наборов: набор тестов Prometheus Remote Write на соответствие требованиям тестирует отправляющую часть протокола Remote Write против наша спецификация.

Во время PromCon в понедельник Том Уилки представил результаты тестов с момента записи несколько недель назад. В живом разделе у него уже было обновление. Два дня спустя у нас есть еще два обновления: Добавлен инструмент конвейера наблюдаемости Vector, а также новые версии существующих систем.

Итак, без лишних слов, текущие результаты в алфавитном порядке:

| Отправитель | Версия | Оценка |

|---|---|---|

| Агент Графана | 0. 13.1 13.1 | 100% |

| Прометей | 2.26.0 | 100% |

| Сборщик OpenTelemetry | 0.26.0 | 41% |

| Телеграф | 1.18.2 | 65% |

| Древесина Вектор | 0.13.1 | 35% |

| Агент VictoriaMetrics | 1.59.0 | 76% |

Необработанные результаты:

--- ПРОЙДЕН: TestRemoteWrite/grafana (0,01 с)

--- ПРОЙДЕНО: TestRemoteWrite/grafana/Counter (10,02 с)

--- ПРОЙДЕНО: TestRemoteWrite/grafana/EmptyLabels (10,02 с)

--- ПРОШЕЛ: TestRemoteWrite/grafana/Gauge (10,02 с)

--- ПРОЙДЕНО: TestRemoteWrite/grafana/Headers (10.02 с)

--- ПРОЙДЕНО: TestRemoteWrite/grafana/Histogram (10,02 с)

--- ПРОЙДЕНО: TestRemoteWrite/grafana/HonorLabels (10,02 с)

--- ПРОЙДЕНО: TestRemoteWrite/grafana/InstanceLabel (10,02 с)

--- ПРОЙДЕНИЕ: TestRemoteWrite/grafana/Invalid (10. 02 с)

--- ПРОЙДЕНО: TestRemoteWrite/grafana/JobLabel (10,02 с)

--- ПРОЙДЕН: TestRemoteWrite/grafana/NameLabel (10.02 с)

--- ПРОЙДЕНО: TestRemoteWrite/grafana/Ordering (26,12 с)

--- ПРОЙДЕНО: TestRemoteWrite/grafana/RepeatedLabels (10,02 с)

--- ПРОЙДЕНО: TestRemoteWrite/grafana/SortedLabels (10,02 с)

--- ПРОЙДЕН: TestRemoteWrite/grafana/Staleness (10.01 с)

--- ПРОЙДИТЕ: TestRemoteWrite/grafana/Summary (10.01 с)

--- ПРОЙДЕНИЕ: TestRemoteWrite/grafana/Timestamp (10.01 с)

--- ПРОЙДЕН: TestRemoteWrite/grafana/Up (10,02 с)

--- ПРОЙДЕН: TestRemoteWrite/prometheus (0,01 с)

--- ПРОЙДЕН: TestRemoteWrite/prometheus/Counter (10,02 с)

--- ПРОЙДЕН: TestRemoteWrite/prometheus/EmptyLabels (10.02 с)

--- ПРОЙДЕН: TestRemoteWrite/prometheus/Gauge (10,02 с)

--- ПРОЙДЕН: TestRemoteWrite/prometheus/Headers (10.02 с)

--- ПРОЙДЕНО: TestRemoteWrite/prometheus/Histogram (10,02 с)

--- ПРОЙДЕНО: TestRemoteWrite/prometheus/HonorLabels (10,02 с)

--- ПРОЙДЕН: TestRemoteWrite/prometheus/InstanceLabel (10,02 с)

--- ПРОЙДЕНИЕ: TestRemoteWrite/prometheus/Invalid (10.

02 с)

--- ПРОЙДЕНО: TestRemoteWrite/grafana/JobLabel (10,02 с)

--- ПРОЙДЕН: TestRemoteWrite/grafana/NameLabel (10.02 с)

--- ПРОЙДЕНО: TestRemoteWrite/grafana/Ordering (26,12 с)

--- ПРОЙДЕНО: TestRemoteWrite/grafana/RepeatedLabels (10,02 с)

--- ПРОЙДЕНО: TestRemoteWrite/grafana/SortedLabels (10,02 с)

--- ПРОЙДЕН: TestRemoteWrite/grafana/Staleness (10.01 с)

--- ПРОЙДИТЕ: TestRemoteWrite/grafana/Summary (10.01 с)

--- ПРОЙДЕНИЕ: TestRemoteWrite/grafana/Timestamp (10.01 с)

--- ПРОЙДЕН: TestRemoteWrite/grafana/Up (10,02 с)

--- ПРОЙДЕН: TestRemoteWrite/prometheus (0,01 с)

--- ПРОЙДЕН: TestRemoteWrite/prometheus/Counter (10,02 с)

--- ПРОЙДЕН: TestRemoteWrite/prometheus/EmptyLabels (10.02 с)

--- ПРОЙДЕН: TestRemoteWrite/prometheus/Gauge (10,02 с)

--- ПРОЙДЕН: TestRemoteWrite/prometheus/Headers (10.02 с)

--- ПРОЙДЕНО: TestRemoteWrite/prometheus/Histogram (10,02 с)

--- ПРОЙДЕНО: TestRemoteWrite/prometheus/HonorLabels (10,02 с)

--- ПРОЙДЕН: TestRemoteWrite/prometheus/InstanceLabel (10,02 с)

--- ПРОЙДЕНИЕ: TestRemoteWrite/prometheus/Invalid (10. 02 с)

--- ПРОЙДЕНО: TestRemoteWrite/prometheus/JobLabel (10,02 с)

--- ПРОЙДЕН: TestRemoteWrite/prometheus/NameLabel (10.03 с)

--- ПРОЙДИТЕ: TestRemoteWrite/prometheus/Ordering (24.99с)

--- ПРОЙДЕН: TestRemoteWrite/prometheus/RepeatedLabels (10.02 с)

--- ПРОЙДЕНО: TestRemoteWrite/prometheus/SortedLabels (10.02 с)

--- ПРОЙДЕН: TestRemoteWrite/prometheus/Staleness (10.02 с)

--- ПРОЙДЕНО: TestRemoteWrite/prometheus/Summary (10,02 с)

--- ПРОЙДИТЕ: TestRemoteWrite/prometheus/Timestamp (10,02 с)

--- ПРОЙДЕНО: TestRemoteWrite/prometheus/Up (10,02 с)

--- FAIL: TestRemoteWrite/otelcollector (0,00 с)

--- FAIL: TestRemoteWrite/otelcollector/Counter (10.01 с)

--- FAIL: TestRemoteWrite/otelcollector/Histogram (10,01 с)

--- FAIL: TestRemoteWrite/otelcollector/InstanceLabel (10.01 с)

--- FAIL: TestRemoteWrite/otelcollector/Invalid (10.01s)

--- FAIL: TestRemoteWrite/otelcollector/JobLabel (10.01 с)

--- FAIL: TestRemoteWrite/otelcollector/Ordering (13,54 с)

--- FAIL: TestRemoteWrite/otelcollector/RepeatedLabels (10.

02 с)

--- ПРОЙДЕНО: TestRemoteWrite/prometheus/JobLabel (10,02 с)

--- ПРОЙДЕН: TestRemoteWrite/prometheus/NameLabel (10.03 с)

--- ПРОЙДИТЕ: TestRemoteWrite/prometheus/Ordering (24.99с)

--- ПРОЙДЕН: TestRemoteWrite/prometheus/RepeatedLabels (10.02 с)

--- ПРОЙДЕНО: TestRemoteWrite/prometheus/SortedLabels (10.02 с)

--- ПРОЙДЕН: TestRemoteWrite/prometheus/Staleness (10.02 с)

--- ПРОЙДЕНО: TestRemoteWrite/prometheus/Summary (10,02 с)

--- ПРОЙДИТЕ: TestRemoteWrite/prometheus/Timestamp (10,02 с)

--- ПРОЙДЕНО: TestRemoteWrite/prometheus/Up (10,02 с)

--- FAIL: TestRemoteWrite/otelcollector (0,00 с)

--- FAIL: TestRemoteWrite/otelcollector/Counter (10.01 с)

--- FAIL: TestRemoteWrite/otelcollector/Histogram (10,01 с)

--- FAIL: TestRemoteWrite/otelcollector/InstanceLabel (10.01 с)

--- FAIL: TestRemoteWrite/otelcollector/Invalid (10.01s)

--- FAIL: TestRemoteWrite/otelcollector/JobLabel (10.01 с)

--- FAIL: TestRemoteWrite/otelcollector/Ordering (13,54 с)

--- FAIL: TestRemoteWrite/otelcollector/RepeatedLabels (10. 01 с)

--- FAIL: TestRemoteWrite/otelcollector/Staleness (10.01 с)

--- FAIL: TestRemoteWrite/otelcollector/Summary (10.01 с)

--- FAIL: TestRemoteWrite/otelcollector/Up (10.01 с)

--- ПРОЙДЕНО: TestRemoteWrite/otelcollector/EmptyLabels (10.01 с)

--- ПРОЙДЕНО: TestRemoteWrite/otelcollector/Gauge (10,01 с)

--- ПРОЙДЕНО: TestRemoteWrite/otelcollector/Headers (10.01 с)

--- ПРОЙДЕНО: TestRemoteWrite/otelcollector/HonorLabels (10.01 с)

--- ПРОЙДЕНО: TestRemoteWrite/otelcollector/NameLabel (10.01 с)

--- ПРОЙДЕНО: TestRemoteWrite/otelcollector/SortedLabels (10.01 с)

--- ПРОЙДЕН: TestRemoteWrite/otelcollector/Timestamp (10,01 с)

--- FAIL: TestRemoteWrite/telegraf (0,01 с)

--- FAIL: TestRemoteWrite/telegraf/EmptyLabels (14,60 с)

--- FAIL: TestRemoteWrite/telegraf/HonorLabels (14,61 с)

--- FAIL: TestRemoteWrite/telegraf/Invalid (14,61 с)

--- FAIL: TestRemoteWrite/telegraf/RepeatedLabels (14,61 с)

--- FAIL: TestRemoteWrite/telegraf/Staleness (14.

01 с)

--- FAIL: TestRemoteWrite/otelcollector/Staleness (10.01 с)

--- FAIL: TestRemoteWrite/otelcollector/Summary (10.01 с)

--- FAIL: TestRemoteWrite/otelcollector/Up (10.01 с)

--- ПРОЙДЕНО: TestRemoteWrite/otelcollector/EmptyLabels (10.01 с)

--- ПРОЙДЕНО: TestRemoteWrite/otelcollector/Gauge (10,01 с)

--- ПРОЙДЕНО: TestRemoteWrite/otelcollector/Headers (10.01 с)

--- ПРОЙДЕНО: TestRemoteWrite/otelcollector/HonorLabels (10.01 с)

--- ПРОЙДЕНО: TestRemoteWrite/otelcollector/NameLabel (10.01 с)

--- ПРОЙДЕНО: TestRemoteWrite/otelcollector/SortedLabels (10.01 с)

--- ПРОЙДЕН: TestRemoteWrite/otelcollector/Timestamp (10,01 с)

--- FAIL: TestRemoteWrite/telegraf (0,01 с)

--- FAIL: TestRemoteWrite/telegraf/EmptyLabels (14,60 с)

--- FAIL: TestRemoteWrite/telegraf/HonorLabels (14,61 с)

--- FAIL: TestRemoteWrite/telegraf/Invalid (14,61 с)

--- FAIL: TestRemoteWrite/telegraf/RepeatedLabels (14,61 с)

--- FAIL: TestRemoteWrite/telegraf/Staleness (14. 59с)

--- FAIL: TestRemoteWrite/telegraf/Up (14,60 с)

--- ПРОЙДЕН: TestRemoteWrite/telegraf/Counter (14,61 с)

--- ПРОЙДЕН: TestRemoteWrite/telegraf/Gauge (14,60 с)

--- ПРОЙДЕН: TestRemoteWrite/telegraf/Headers (14,61 с)

--- ПРОЙДЕНО: TestRemoteWrite/telegraf/Histogram (14,61 с)

--- ПРОЙДЕНО: TestRemoteWrite/telegraf/InstanceLabel (14,61 с)

--- ПРОЙДЕНО: TestRemoteWrite/telegraf/JobLabel (14,61 с)

--- ПРОЙДЕН: TestRemoteWrite/telegraf/NameLabel (14,60 с)

--- ПРОЙДИТЕ: TestRemoteWrite/telegraf/Ordering (14,61 с)

--- ПРОЙДЕНО: TestRemoteWrite/telegraf/SortedLabels (14,61 с)

--- ПРОЙДИТЕ: TestRemoteWrite/telegraf/Summary (14,60 с)

--- ПРОЙДЕНИЕ: TestRemoteWrite/telegraf/Timestamp (14,61 с)

--- FAIL: TestRemoteWrite/vector (0,01 с)

--- FAIL: TestRemoteWrite/vector/Counter (10,02 с)

--- FAIL: TestRemoteWrite/vector/EmptyLabels (10.01 с)

--- FAIL: TestRemoteWrite/vector/Headers (10.02 с)

--- FAIL: TestRemoteWrite/vector/HonorLabels (10,02 с)

--- FAIL: TestRemoteWrite/vector/InstanceLabel (10,02 с)

--- FAIL: TestRemoteWrite/vector/Invalid (10.

59с)

--- FAIL: TestRemoteWrite/telegraf/Up (14,60 с)

--- ПРОЙДЕН: TestRemoteWrite/telegraf/Counter (14,61 с)

--- ПРОЙДЕН: TestRemoteWrite/telegraf/Gauge (14,60 с)

--- ПРОЙДЕН: TestRemoteWrite/telegraf/Headers (14,61 с)

--- ПРОЙДЕНО: TestRemoteWrite/telegraf/Histogram (14,61 с)

--- ПРОЙДЕНО: TestRemoteWrite/telegraf/InstanceLabel (14,61 с)

--- ПРОЙДЕНО: TestRemoteWrite/telegraf/JobLabel (14,61 с)

--- ПРОЙДЕН: TestRemoteWrite/telegraf/NameLabel (14,60 с)

--- ПРОЙДИТЕ: TestRemoteWrite/telegraf/Ordering (14,61 с)

--- ПРОЙДЕНО: TestRemoteWrite/telegraf/SortedLabels (14,61 с)

--- ПРОЙДИТЕ: TestRemoteWrite/telegraf/Summary (14,60 с)

--- ПРОЙДЕНИЕ: TestRemoteWrite/telegraf/Timestamp (14,61 с)

--- FAIL: TestRemoteWrite/vector (0,01 с)

--- FAIL: TestRemoteWrite/vector/Counter (10,02 с)

--- FAIL: TestRemoteWrite/vector/EmptyLabels (10.01 с)

--- FAIL: TestRemoteWrite/vector/Headers (10.02 с)

--- FAIL: TestRemoteWrite/vector/HonorLabels (10,02 с)